Montag, 14. Juli 2008

Feldbefreier in den Knast

Michael Grolm, der mit der Initiative »Gendreck weg« gentechnisch veränderte Felder »befreit«, muß für zwei Tage in den Knast. Mehr bei ZEIT, Zuender.

Freitag, 11. Juli 2008

Exkurs zu den Anfängen

Kosmologisches Standardmodell

Das kosmologische Standardmodell ist eine mathematisch-physikalische Darstellung des Kosmos in seiner Entwicklung und seinem gegenwärtigen Zustand, so weit wir heute darüber Bescheid wissen. Diese Darstellung stammt in ihren wesentlichen Teilen aus der ersten Hälfte des 20. Jahrhunderts und fasst nahezu sämtliche astronomischen Beobachtungen mit einem Großteil unseres physikalischen Wissens zu einer kohärenten Einheit zusammen, deren Voraussagen seitdem im Wesentlichen verifiziert werden konnten. Auch wenn andere Modelle durchaus denkbar waren (siehe KOSMOLOGIE), hat doch keines von ihnen die Kohärenz erreicht, die das kosmologische Standardmodell eben zum anerkannten Standard gemacht hat. Das von diesem Modell entworfene Szenario funktioniert bemerkenswert gut – zu gut, wie manche meinen, die ihm eine übergroße Hegemonie vorwerfen. Die Zukunft wird zeigen, ob die weitere Erforschung des Universums zu Beobachtungen führt, die das Standardmodell radikal infrage stellen.

Das kosmologische Standardmodell beschreibt das Universum vornehmlich in sehr großem Maßstab. Phänomene geringerer Größenordnung wie der innere Aufbau der GALAXIEN, der STERNE und der möglicherweise vorhandenen PLANETEN bleiben zumindest in einem ersten Schritt unberücksichtigt. Nach dem Standardmodell ist der Kosmos homogen und sowohl von MATERIE als auch von ENERGIE in Form von LICHT und sonstiger Strahlung erfüllt. Die Dichte der Materie und der Energie wird als gleichförmig unterstellt – wie in einer Flüssigkeit oder einem Gas, dessen einzelne Moleküle man außer Acht lässt, um sie als homogenes Medium zu betrachten.

Das Modell soll drei wichtige Phänomene erklären, die sich aus der Beobachtung ergeben: die Expansion des Universums (oder die ständig wachsende Entfernung zwischen den Galaxien) und deren Veränderung im Laufe der Zeit; das Vorkommen leichter chemischer Elemente wie HELIUM in der Materie des Sonnensystems und der Sterne, die im heute beobachteten Ausmaß nicht allein in den Sternen erzeugt worden sein können; und das Vorhandensein einer schwachen Strahlung mit Wellenlängen im Umfeld von einem Millimeter, also im Bereich der Radiowellen und des Submillimeterbereichs die den gesamten Kosmos erfüllt und sich von der Strahlung der Sterne oder Galaxien unterscheidet (siehe SCHWARZER KÖRPER). Darüber hinaus soll und kann das Modell auch einige andere Phänomene erklären, deren Beobachtung noch nicht so weit fortgeschritten ist, etwa die Verteilung der Galaxien im Raum und deren hierarchische Anordnung zu HAUFEN, die wie russische Puppen ineinander verschachtelt sind, oder auch die Existenz der geheimnisvollen dunklen MASSE in den Galaxien.

Innerhalb der Physik fügt sich das Modell zwanglos in den mathematischen Begriffsrahmen der allgemeinen Relativitätstheorie ein, denn in den dort betrachteten Größenordnungen spielt die GRAVITATION eine zentrale Rolle. Auch Kern- und Teilchenphysik haben große Bedeutung, weil das Modell beschreibt, wie die PROTONEN und NEUTRONEN, aus denen die Kerne aller chemischen Elemente aufgebaut sind, und im weiteren Verlauf die chemischen Elemente selbst entstehen (siehe ENTSTEHUNG DER ELEMENTE).

Das Modell in seinem zeitlichen Ablauf

Ein von Materie und Energie erfülltes Universum kann nicht stabil sein; es stürzt entweder in sich zusammen oder expandiert (siehe GRAVITATIONSKOLLAPS). Die Relativitätstheorie bestätigt diese Auffassung und geht davon aus, dass die Dimensionen des Raums sich mit der Zeit verändern, und zwar mit der so genannten kosmischen Zeit, die unabhängig von dem Ort ist, an dem man sich gerade befindet; und an dieser Zeit orientiert man sich bei der Abfolge der kosmischen Ereignisse.

Betrachten wir eine beliebige Länge a(t), so ist die Veränderung, die diese Länge in der Zeit erfährt, durch den Ausdruck a(t) = a(t0)R(t) gegeben, wobei a(t0) den Wert dieser Größe zu einem Zeitpunkt t0, dem Bezugszeitpunkt, und R(t) den Expansionskoeffizienten bezeichnet, eine universelle, das heißt an jedem Ort und zu jedem Zeitpunkt anwendbare Größe, die mit der Zeit t zunimmt und in der die Expansion des Universums zum Ausdruck kommt. Setzen wir t0 für R(t0) = 1, dann war R(t) nach dem obigen Ausdruck in der Vergangenheit kleiner als 1 und wird der Zukunft größer als 1 sein.

Auf der Grundlage der allgemeinen Relativitätstheorie, die das Newtonsche Verständnis der Gravitation in einen ganz neuen Rahmen setzt (nämlich in den der RAUMZEIT) stellt das kosmologische Standardmodell Gleichungen zur Verfügung, mit denen sich die Funktion R(t) vollständig bestimmen läßt, sofern man bestimmte Größen oder Parameter spezifiziert, die man aus der Beobachtung ableiten zu können hofft.

In erster Linie handelt es sich dabei um die Expansionsgeschwindigkeit (oder Expansionsrate), wie sie heute festzustellen ist. Leider ergibt diese Messung nicht den Wert Von R(t), sondern eine mit dessen Veränderung (oder Ableitung) verbundene Größe H(t), die folgendermaßen definiert ist:

H(t) = [1/R(t)} {dR(t)/dt].

Heute (t=t0) entspricht diese Größe genau der Hubble-Konstanten H(t0) oder einfach H (siehe EXPANSION und NATURKONSTANTEN).

Hinzu kommt als zweites die Materiedichte ρ (Rho, gemessen in kg/m3 [pro Kubikmeter]) im gegenwärtigen Universum, die aus der MASSE aller bekannten Galaxien und der Ausdehnung des bekannten Universums errechnet wird.

Die dritte Größe ist die Energiedichte ρl, die mit der im heutigen Universum anzutreffenden elektromagnetischen Strahlung zusammenhängt, hauptsächlich mit der Strahlung des SCHWARZEN KÖRPERS, denn die Sterne sind in diesen Größenordnungen nur schwache lokale Leuchten (siehe PARADOXON DES DUNKLEN NACHTHIMMELS).

Möglicherweise kommt noch eine vierte Größe hinzu, die kosmologische Konstante, und die die ganze Sache komplizieren würde, doch wir wollen sie hier außer Acht lassen (siehe NATURKONSTANTEN).

Rechnet man das Modell durch, ergeben sich mehrere grundlegende Möglichkeiten, je nachdem, von welcher Gesamtdichte (Materie + Energie) man ausgeht. Wenn diese Dichte sehr gering ist, dehnt sich das Universum bis in alle Ewigkeit weiter aus, und seine Raum-Zeit hat dann eine Geometrie, man als »offen« bezeichnet (siehe KRÜMMUNG und UNENDLICH). Im umgekehrten Fall wechseln Phasen der Expansion und der Kontraktion (Gravitationskollaps) einander ab und die Geometrie der Raum-Zeit ist »geschlossen«. Die Grenze zwischen beiden Möglichkeiten ist durch die so genannte kritische Gesamtdichte ρk markiert, und der Bequemlichkeit halber drückt man die gemessenen Dichten sogar im Verhältnis zu dieser kritischen Dichte aus und schreibt: Ωm = ρm/ρk und Ωl = ρl/ρk. Wenn die Dichte genau der kritischen Dichte entspricht, dehnt sich das Universum immer noch endlos aus.

In beiden Fällen ergibt sich aus dem Modell die zeitliche Entwicklung der Größen H(t), Ωm(t), Ωl(t) sowie R(t). Auf der Grundlage der heute gemessenen Werte für Ωm(t) und Ωl(t) lässt sich diese Entwicklung auch in die Vergangenheit zurückverfolgen, so dass man die Ausdehnung des Universums (über H(t)), den Umfang der jeweils vorhandenen Materie (über Ωm(t)) und der Strahlung (über Ωl(t)) sowie in groben Zügen auch die Phänomene bestimmen kann, die für bestimmte Phasen der bisherigen Entwicklung des Universums charakteristisch waren.

In allen Fällen führt das Modell für den Anfangszeitpunkt t = 0 (den man als kosmische SINGULARITÄT bezeichnet) zu einer unendlichen Dichte. Dieser Wert hat keine physikalische Bedeutung, sondern markiert die Grenze der in das Modell eingebrachten Hypothesen. Was damals in unmittelbarer zeitlicher Nähe zur Singularität geschah, wird vielfach als Urknall bezeichnet, aber es ist angebracht, diesen Gedanken eines Anfangs des Universums nur mit Vorsicht zu formulieren (siehe dazu auch SCHÖPFUNG).

Durch die Expansion des Universums verändert sich die Wellenlänge des Lichts zwischen dem Zeitpunkt seiner Emission und dem Zeitpunkt t0, in dem wir es empfangen, denn die Expansion hat Auswirkungen auf R(t), also auf den Raum, in dem das Lieht sich ausbreitet. Da wir davon ausgehen, daß bestimmte Atome (zum Beispiel ein Wasserstoffatom) unabhängig von Zeit und Ort stets Licht derselben Wellenlänge λ0 emittieren, bietet uns die Messung der empfangenen Wellenlänge einen direkten Zugang zur Expansion des Universums, und auf diesem Wege wurde sie auch 1929 von Edwin Hubble entdeckt.

Die relative Veränderung der empfangenen Wellenlänge λ gegenüber der emittierten Wellenlänge λ0 bezeichnet man als Rotverschiebung z des Lichts im Universum und schreibt: z = (λ-λ0)/λ0.

Für den jeweiligen Expansionskoeffizienten R(t) zum Zeitpunkt t der Emission des Lichts ergibt sich die Rotversehiebung z aus der Formel z(t) = [R(to)/R(t)]-1.

Wenn wir nun die Rotverschiebung des mit unseren Spiegelteleskopen aufgefangenen Lichts bestimmen (siehe SPEKTRUM), können wir auch den Wert von R(t) für den Zeitpunkt bestimmen, zu dem das betreffende Licht emittiert wurde. Die größte an identifizierten Objekten (GALAXIEN und QUASAREN) beobachtete Rotverschiebung bleibt unterhalb des Werts von z=5. Weiter ins All hineinzuschauen übersteigt gegenwärtig noch die Lichtstärke und das Auflösungsvermögen unserer TELESKOPE.

Durch die Beobachtung von Objekten, deren Licht immer größere Rotverschiebung aufweist, können wir R(t) bestimmen und immer weiter zurück in die Vergangenheit des Universums schauen.

Materie und Strahlung

Heute spielt die Strahlung nur noch eine untergeordnete Rolle im Universum, dessen dynamische Entwicklung vor allem durch die darin enthaltene Materie bestimmt wird. Die Strahlungsdichte ist um den Faktor 1000 geringer als die Materiedichte; außerdem ist die Strahlung weitgehend von der Materie abgekoppelt, und die Wechselwirkung zwischen beiden ist praktisch vernachlässigbaR. Unsere größte Unsicherheit resultiert aus der Tatsache, dass wir nicht genau wissen, wie viel Materie das Universum gegenwärtig enthält. Wenn die Gesamtmasse sich auf die der heute beobachtbaren Sterne und Galaxien beschränkt, bleibt die Materiedichte weit unterhalb der kritischen Dichte (und zwar um einen Faktor von 20 bis 50), und wir haben es mit einem offenen Universum zu tun, das sich bis in alle Ewigkeit weiter ausdehnt.

Wenn wir die an lokalen Gravitationseffekten erkennbare DUNKLE MASSE Berücksichtigen, kommen wir der kritischen Dichte schon näher, bleiben aber immer noch um den Faktor 5 darunter. Andere Beobachtungen (zum Beispiel Veränderungen der Expansionsgeschwindigkeit in ferner Vergangenheit, das heißt für Rotverschiebungen oberhalb des Wertes 1) rechtfertigen jedoch die Vermutung, dass die Dichte fast genau der kritischen Dichte entspricht.

Bevor die Sterne entstanden und die Kernfusion im Innern der Sterne Energie freizusetzen begann, sollen Strahlung und Materie in einem GLEICHGEWICHT gestanden haben. Solch ein statistisches Gleichgewicht (siehe THERMODYNAMIK) findet seinen Ausdruck in einer für Materie und Strahlung identischen TEMPERATUR T. Die Strahlungstemperatur steht in einem direkten Zusammenhang mit der Verteilung des Lichts auf die verschiedenen Wellenlängen (siehe SPEKTRUM und SCHWARZER KÖRPER). Das kosmologische Standardmodell geht davon, dass diese Temperatur T(t) sich mit der Zeit verändert, oder genauer: dass sie mit der Zeit immer kleiner wird, so dass wir zu immer höheren Temperaturen von Tausenden, Millionen oder sogar Milliarden Kelvin gelangen, je weiter wir in der Zeit zurückgehen.

Diese Werte sind Ausdruck der im Raum anzutreffenden Energiedichte, also einerseits einer im Rückblick immer stärkeren thermischen Bewegung von Materieteilchen oder andererseits einer Strahlung, deren Energie immer weiter zunimmt, je weiter wir in die Vergangenheit zurückgehen (wobei der Schwerpunkt der Wellenlängen sich mit wachsender Temperatur vom Infrarotbereieh über das sichtbare und ultraviolette Licht his hin zu Röntgen- und Gammastrahlung verlagert).

Da das Modell so extreme Temperaturen vorsieht und da sich für die Materiedichte Ωm(t) und die Strahlungsdichte Ωl(t) ganz unterschiedliche Entwicklungen ergeben, muss das Universum in der Vergangenheit ganz anders beschaffen gewesen sein als heute, und daraus folgt, dass es eine EVOLUTION erfahren hat. Darin liegt ohne Zweifel eine der fundamentalsten Aussagen des kosmologischen Standardmodells. Heute entwickeln Strahlung und Materie sich unabhängig voneinander. Es gab jedoch eine Zeit – nennen wir sie tR -, da waren beide Dichtewerte gleich. Und vor tR besaß die Strahlung Weitaus größere Bedeutung als die Materie.

Welche Situation bestand nun zu dieser Zeit tR? Damals war die thermische Bewegung der Teilchen so gering (entspricht einer Temperatur von etwa 3000 Kelvin), dass die noch recht homogen im Raum verteilten Protonen und Elektronen sich zu neutralen Wasserstoffatomen verbinden konnten. Diese als Rekombination bezeichnete Verbindung erfolgte im Gleichgewicht mit einer Strahlung, deren vorherrschende Wellenlänge durch die damals herrschende Temperatur bestimmt wurde.

Nach den Gesetzen des Schwarzen Körpers dürfte diese Wellenlänge bei etwa einem Mikrometer (λ0 = 10-6m [10 hoch minus 6 Meter]) gelegen haben. Das mit neutralen Wasserstoffatomen erfüllte Universum wurde plötzlich vollkommen durchsichtig für die PHOTONEN, die ihren Weg nun ungehindert fortsetzen konnten. Doch aufgrund der Expansion des Universums erfuhr diese Wellenlänge eine beständige Dilatation und liegt heute im Bereich von etwa einem Millimeter (10-3m [10 hoch minus 3 Meter]).

Die Rotverschiebung z gegenüber dem Zeitpunkt der Emission beträgt demnach z = (λ-λ0)/λ0 ≈ 1000, wobei der Index R auf die Zeit der Rekombination verweist. Diese Strahlung ist also sehr viel älter als das Licht, das heute von den entferntesten bekannten Galaxien zu uns gelangt, denn für dieses Licht ist z ≤ 5.

Vor der Rekombination des Wasserstoffs

Das Modell gestattet es also, die Entwicklung der Dichte und der Temperatur des Universums bis in die fernste Vergangenheit zurückzuverfolgen. Da wir die Gesetze kennen, die das Verhalten der Materie bei solchen Dichte und Temperaturverhältnissen beherrschen (siehe ZUSTANDSGLEICHUNG), können wir uns vorstellen, was in diesen fernen Zeiten geschehen sein könnte.

Daher suchen die Astrophvsiker in unserem heutigen Universum nach „fossilen“ Spuren der damaligen Ereignisse. Im Einzelnen ergibt sich für die Abfolge der Phänomene mit abnehmender Temperatur des Universums folgendes Bild: Zunächst entstanden die Elementarteilchen, die man als QUARKS bezeichnet, und aus ihnen wiederum Protonen und Neutronen; diese zerstrahlten gemeinsam mit ihren jeweiligen ANTITEILCHEN, so dass nur ein kleiner Rest an Nukleonen (unsere Materie) übrig blieb; diese Nukleonen verbanden sich dann zu Heliumkernen und anderen leichten chemischen Elementen (siehe ENTSTEHUNG DER ELEMENTE); und schließlich bildete sich der Wasserstoff, das im heutigen Universum häufigste Element, aus der Verbindung der restlichen Protonen und Elektronen.

Aber was geschah vor alledem? Dass die Dichte im Universum heute ausgerechnet einen Wert hat, der praktisch der kritischen Dichte entspricht, stört die Physiker, die das Allgemeingültige lieben und Zufälle hassen. Daher haben sie einen Mechanismus erdacht, der unmittelbar vor den oben beschriebenen Phasen abgelaufen sein soll und das Universum, wie immer es beschaffen gewesen mag, unter möglichst vielen denkbaren Umstünden doch stets auf den Weg zu seinem heutigen Zustand gebracht haben könnte, also genau an die Grenze zwischen einem »offenen« und einem »geschlossenen« Universum. Dieser Mechanismus ist eine extrem starke Expansion, die als INFLATION bezeichnet wird.

Und was war davor? Mit der Inflation erreichen wir die Grenzen der Physik, auf der das Standardmodell aufbaut. Von entscheidender Bedeutung ist dabei das Bild, das die Physik sich von der Gravitation in einem Zustand der Materie und der Energie machen, in dem der quantenphysikalische Charakter der an der gravitativen Wechselwirkung beteiligten Austauschprozesse nicht mehr vernachlässigt werden kann (siehe QUANTENPHYSIK).

Der Wert der kosmischen Zeit t, in der diese Situation eingetreten sein dürfte, ist unvorstellbar klein. Er liegt in der Größenordnung von 10-44 s [10 hoch minus 44 Sekunden] nach der Singularität (to) und wird als Planck-Zeit bezeichnet (siehe GRAVITATION). Über alles, was davor geschehen sein mag, wem das Modell nichts zu sagen.

Das kosmologische Standardmodell ist eine mathematisch-physikalische Darstellung des Kosmos in seiner Entwicklung und seinem gegenwärtigen Zustand, so weit wir heute darüber Bescheid wissen. Diese Darstellung stammt in ihren wesentlichen Teilen aus der ersten Hälfte des 20. Jahrhunderts und fasst nahezu sämtliche astronomischen Beobachtungen mit einem Großteil unseres physikalischen Wissens zu einer kohärenten Einheit zusammen, deren Voraussagen seitdem im Wesentlichen verifiziert werden konnten. Auch wenn andere Modelle durchaus denkbar waren (siehe KOSMOLOGIE), hat doch keines von ihnen die Kohärenz erreicht, die das kosmologische Standardmodell eben zum anerkannten Standard gemacht hat. Das von diesem Modell entworfene Szenario funktioniert bemerkenswert gut – zu gut, wie manche meinen, die ihm eine übergroße Hegemonie vorwerfen. Die Zukunft wird zeigen, ob die weitere Erforschung des Universums zu Beobachtungen führt, die das Standardmodell radikal infrage stellen.

Das kosmologische Standardmodell beschreibt das Universum vornehmlich in sehr großem Maßstab. Phänomene geringerer Größenordnung wie der innere Aufbau der GALAXIEN, der STERNE und der möglicherweise vorhandenen PLANETEN bleiben zumindest in einem ersten Schritt unberücksichtigt. Nach dem Standardmodell ist der Kosmos homogen und sowohl von MATERIE als auch von ENERGIE in Form von LICHT und sonstiger Strahlung erfüllt. Die Dichte der Materie und der Energie wird als gleichförmig unterstellt – wie in einer Flüssigkeit oder einem Gas, dessen einzelne Moleküle man außer Acht lässt, um sie als homogenes Medium zu betrachten.

Das Modell soll drei wichtige Phänomene erklären, die sich aus der Beobachtung ergeben: die Expansion des Universums (oder die ständig wachsende Entfernung zwischen den Galaxien) und deren Veränderung im Laufe der Zeit; das Vorkommen leichter chemischer Elemente wie HELIUM in der Materie des Sonnensystems und der Sterne, die im heute beobachteten Ausmaß nicht allein in den Sternen erzeugt worden sein können; und das Vorhandensein einer schwachen Strahlung mit Wellenlängen im Umfeld von einem Millimeter, also im Bereich der Radiowellen und des Submillimeterbereichs die den gesamten Kosmos erfüllt und sich von der Strahlung der Sterne oder Galaxien unterscheidet (siehe SCHWARZER KÖRPER). Darüber hinaus soll und kann das Modell auch einige andere Phänomene erklären, deren Beobachtung noch nicht so weit fortgeschritten ist, etwa die Verteilung der Galaxien im Raum und deren hierarchische Anordnung zu HAUFEN, die wie russische Puppen ineinander verschachtelt sind, oder auch die Existenz der geheimnisvollen dunklen MASSE in den Galaxien.

Innerhalb der Physik fügt sich das Modell zwanglos in den mathematischen Begriffsrahmen der allgemeinen Relativitätstheorie ein, denn in den dort betrachteten Größenordnungen spielt die GRAVITATION eine zentrale Rolle. Auch Kern- und Teilchenphysik haben große Bedeutung, weil das Modell beschreibt, wie die PROTONEN und NEUTRONEN, aus denen die Kerne aller chemischen Elemente aufgebaut sind, und im weiteren Verlauf die chemischen Elemente selbst entstehen (siehe ENTSTEHUNG DER ELEMENTE).

Das Modell in seinem zeitlichen Ablauf

Ein von Materie und Energie erfülltes Universum kann nicht stabil sein; es stürzt entweder in sich zusammen oder expandiert (siehe GRAVITATIONSKOLLAPS). Die Relativitätstheorie bestätigt diese Auffassung und geht davon aus, dass die Dimensionen des Raums sich mit der Zeit verändern, und zwar mit der so genannten kosmischen Zeit, die unabhängig von dem Ort ist, an dem man sich gerade befindet; und an dieser Zeit orientiert man sich bei der Abfolge der kosmischen Ereignisse.

Betrachten wir eine beliebige Länge a(t), so ist die Veränderung, die diese Länge in der Zeit erfährt, durch den Ausdruck a(t) = a(t0)R(t) gegeben, wobei a(t0) den Wert dieser Größe zu einem Zeitpunkt t0, dem Bezugszeitpunkt, und R(t) den Expansionskoeffizienten bezeichnet, eine universelle, das heißt an jedem Ort und zu jedem Zeitpunkt anwendbare Größe, die mit der Zeit t zunimmt und in der die Expansion des Universums zum Ausdruck kommt. Setzen wir t0 für R(t0) = 1, dann war R(t) nach dem obigen Ausdruck in der Vergangenheit kleiner als 1 und wird der Zukunft größer als 1 sein.

Auf der Grundlage der allgemeinen Relativitätstheorie, die das Newtonsche Verständnis der Gravitation in einen ganz neuen Rahmen setzt (nämlich in den der RAUMZEIT) stellt das kosmologische Standardmodell Gleichungen zur Verfügung, mit denen sich die Funktion R(t) vollständig bestimmen läßt, sofern man bestimmte Größen oder Parameter spezifiziert, die man aus der Beobachtung ableiten zu können hofft.

In erster Linie handelt es sich dabei um die Expansionsgeschwindigkeit (oder Expansionsrate), wie sie heute festzustellen ist. Leider ergibt diese Messung nicht den Wert Von R(t), sondern eine mit dessen Veränderung (oder Ableitung) verbundene Größe H(t), die folgendermaßen definiert ist:

H(t) = [1/R(t)} {dR(t)/dt].

Heute (t=t0) entspricht diese Größe genau der Hubble-Konstanten H(t0) oder einfach H (siehe EXPANSION und NATURKONSTANTEN).

Hinzu kommt als zweites die Materiedichte ρ (Rho, gemessen in kg/m3 [pro Kubikmeter]) im gegenwärtigen Universum, die aus der MASSE aller bekannten Galaxien und der Ausdehnung des bekannten Universums errechnet wird.

Die dritte Größe ist die Energiedichte ρl, die mit der im heutigen Universum anzutreffenden elektromagnetischen Strahlung zusammenhängt, hauptsächlich mit der Strahlung des SCHWARZEN KÖRPERS, denn die Sterne sind in diesen Größenordnungen nur schwache lokale Leuchten (siehe PARADOXON DES DUNKLEN NACHTHIMMELS).

Möglicherweise kommt noch eine vierte Größe hinzu, die kosmologische Konstante, und die die ganze Sache komplizieren würde, doch wir wollen sie hier außer Acht lassen (siehe NATURKONSTANTEN).

Rechnet man das Modell durch, ergeben sich mehrere grundlegende Möglichkeiten, je nachdem, von welcher Gesamtdichte (Materie + Energie) man ausgeht. Wenn diese Dichte sehr gering ist, dehnt sich das Universum bis in alle Ewigkeit weiter aus, und seine Raum-Zeit hat dann eine Geometrie, man als »offen« bezeichnet (siehe KRÜMMUNG und UNENDLICH). Im umgekehrten Fall wechseln Phasen der Expansion und der Kontraktion (Gravitationskollaps) einander ab und die Geometrie der Raum-Zeit ist »geschlossen«. Die Grenze zwischen beiden Möglichkeiten ist durch die so genannte kritische Gesamtdichte ρk markiert, und der Bequemlichkeit halber drückt man die gemessenen Dichten sogar im Verhältnis zu dieser kritischen Dichte aus und schreibt: Ωm = ρm/ρk und Ωl = ρl/ρk. Wenn die Dichte genau der kritischen Dichte entspricht, dehnt sich das Universum immer noch endlos aus.

In beiden Fällen ergibt sich aus dem Modell die zeitliche Entwicklung der Größen H(t), Ωm(t), Ωl(t) sowie R(t). Auf der Grundlage der heute gemessenen Werte für Ωm(t) und Ωl(t) lässt sich diese Entwicklung auch in die Vergangenheit zurückverfolgen, so dass man die Ausdehnung des Universums (über H(t)), den Umfang der jeweils vorhandenen Materie (über Ωm(t)) und der Strahlung (über Ωl(t)) sowie in groben Zügen auch die Phänomene bestimmen kann, die für bestimmte Phasen der bisherigen Entwicklung des Universums charakteristisch waren.

In allen Fällen führt das Modell für den Anfangszeitpunkt t = 0 (den man als kosmische SINGULARITÄT bezeichnet) zu einer unendlichen Dichte. Dieser Wert hat keine physikalische Bedeutung, sondern markiert die Grenze der in das Modell eingebrachten Hypothesen. Was damals in unmittelbarer zeitlicher Nähe zur Singularität geschah, wird vielfach als Urknall bezeichnet, aber es ist angebracht, diesen Gedanken eines Anfangs des Universums nur mit Vorsicht zu formulieren (siehe dazu auch SCHÖPFUNG).

Durch die Expansion des Universums verändert sich die Wellenlänge des Lichts zwischen dem Zeitpunkt seiner Emission und dem Zeitpunkt t0, in dem wir es empfangen, denn die Expansion hat Auswirkungen auf R(t), also auf den Raum, in dem das Lieht sich ausbreitet. Da wir davon ausgehen, daß bestimmte Atome (zum Beispiel ein Wasserstoffatom) unabhängig von Zeit und Ort stets Licht derselben Wellenlänge λ0 emittieren, bietet uns die Messung der empfangenen Wellenlänge einen direkten Zugang zur Expansion des Universums, und auf diesem Wege wurde sie auch 1929 von Edwin Hubble entdeckt.

Die relative Veränderung der empfangenen Wellenlänge λ gegenüber der emittierten Wellenlänge λ0 bezeichnet man als Rotverschiebung z des Lichts im Universum und schreibt: z = (λ-λ0)/λ0.

Für den jeweiligen Expansionskoeffizienten R(t) zum Zeitpunkt t der Emission des Lichts ergibt sich die Rotversehiebung z aus der Formel z(t) = [R(to)/R(t)]-1.

Wenn wir nun die Rotverschiebung des mit unseren Spiegelteleskopen aufgefangenen Lichts bestimmen (siehe SPEKTRUM), können wir auch den Wert von R(t) für den Zeitpunkt bestimmen, zu dem das betreffende Licht emittiert wurde. Die größte an identifizierten Objekten (GALAXIEN und QUASAREN) beobachtete Rotverschiebung bleibt unterhalb des Werts von z=5. Weiter ins All hineinzuschauen übersteigt gegenwärtig noch die Lichtstärke und das Auflösungsvermögen unserer TELESKOPE.

Durch die Beobachtung von Objekten, deren Licht immer größere Rotverschiebung aufweist, können wir R(t) bestimmen und immer weiter zurück in die Vergangenheit des Universums schauen.

Materie und Strahlung

Heute spielt die Strahlung nur noch eine untergeordnete Rolle im Universum, dessen dynamische Entwicklung vor allem durch die darin enthaltene Materie bestimmt wird. Die Strahlungsdichte ist um den Faktor 1000 geringer als die Materiedichte; außerdem ist die Strahlung weitgehend von der Materie abgekoppelt, und die Wechselwirkung zwischen beiden ist praktisch vernachlässigbaR. Unsere größte Unsicherheit resultiert aus der Tatsache, dass wir nicht genau wissen, wie viel Materie das Universum gegenwärtig enthält. Wenn die Gesamtmasse sich auf die der heute beobachtbaren Sterne und Galaxien beschränkt, bleibt die Materiedichte weit unterhalb der kritischen Dichte (und zwar um einen Faktor von 20 bis 50), und wir haben es mit einem offenen Universum zu tun, das sich bis in alle Ewigkeit weiter ausdehnt.

Wenn wir die an lokalen Gravitationseffekten erkennbare DUNKLE MASSE Berücksichtigen, kommen wir der kritischen Dichte schon näher, bleiben aber immer noch um den Faktor 5 darunter. Andere Beobachtungen (zum Beispiel Veränderungen der Expansionsgeschwindigkeit in ferner Vergangenheit, das heißt für Rotverschiebungen oberhalb des Wertes 1) rechtfertigen jedoch die Vermutung, dass die Dichte fast genau der kritischen Dichte entspricht.

Bevor die Sterne entstanden und die Kernfusion im Innern der Sterne Energie freizusetzen begann, sollen Strahlung und Materie in einem GLEICHGEWICHT gestanden haben. Solch ein statistisches Gleichgewicht (siehe THERMODYNAMIK) findet seinen Ausdruck in einer für Materie und Strahlung identischen TEMPERATUR T. Die Strahlungstemperatur steht in einem direkten Zusammenhang mit der Verteilung des Lichts auf die verschiedenen Wellenlängen (siehe SPEKTRUM und SCHWARZER KÖRPER). Das kosmologische Standardmodell geht davon, dass diese Temperatur T(t) sich mit der Zeit verändert, oder genauer: dass sie mit der Zeit immer kleiner wird, so dass wir zu immer höheren Temperaturen von Tausenden, Millionen oder sogar Milliarden Kelvin gelangen, je weiter wir in der Zeit zurückgehen.

Diese Werte sind Ausdruck der im Raum anzutreffenden Energiedichte, also einerseits einer im Rückblick immer stärkeren thermischen Bewegung von Materieteilchen oder andererseits einer Strahlung, deren Energie immer weiter zunimmt, je weiter wir in die Vergangenheit zurückgehen (wobei der Schwerpunkt der Wellenlängen sich mit wachsender Temperatur vom Infrarotbereieh über das sichtbare und ultraviolette Licht his hin zu Röntgen- und Gammastrahlung verlagert).

Da das Modell so extreme Temperaturen vorsieht und da sich für die Materiedichte Ωm(t) und die Strahlungsdichte Ωl(t) ganz unterschiedliche Entwicklungen ergeben, muss das Universum in der Vergangenheit ganz anders beschaffen gewesen sein als heute, und daraus folgt, dass es eine EVOLUTION erfahren hat. Darin liegt ohne Zweifel eine der fundamentalsten Aussagen des kosmologischen Standardmodells. Heute entwickeln Strahlung und Materie sich unabhängig voneinander. Es gab jedoch eine Zeit – nennen wir sie tR -, da waren beide Dichtewerte gleich. Und vor tR besaß die Strahlung Weitaus größere Bedeutung als die Materie.

Welche Situation bestand nun zu dieser Zeit tR? Damals war die thermische Bewegung der Teilchen so gering (entspricht einer Temperatur von etwa 3000 Kelvin), dass die noch recht homogen im Raum verteilten Protonen und Elektronen sich zu neutralen Wasserstoffatomen verbinden konnten. Diese als Rekombination bezeichnete Verbindung erfolgte im Gleichgewicht mit einer Strahlung, deren vorherrschende Wellenlänge durch die damals herrschende Temperatur bestimmt wurde.

Nach den Gesetzen des Schwarzen Körpers dürfte diese Wellenlänge bei etwa einem Mikrometer (λ0 = 10-6m [10 hoch minus 6 Meter]) gelegen haben. Das mit neutralen Wasserstoffatomen erfüllte Universum wurde plötzlich vollkommen durchsichtig für die PHOTONEN, die ihren Weg nun ungehindert fortsetzen konnten. Doch aufgrund der Expansion des Universums erfuhr diese Wellenlänge eine beständige Dilatation und liegt heute im Bereich von etwa einem Millimeter (10-3m [10 hoch minus 3 Meter]).

Die Rotverschiebung z gegenüber dem Zeitpunkt der Emission beträgt demnach z = (λ-λ0)/λ0 ≈ 1000, wobei der Index R auf die Zeit der Rekombination verweist. Diese Strahlung ist also sehr viel älter als das Licht, das heute von den entferntesten bekannten Galaxien zu uns gelangt, denn für dieses Licht ist z ≤ 5.

Vor der Rekombination des Wasserstoffs

Das Modell gestattet es also, die Entwicklung der Dichte und der Temperatur des Universums bis in die fernste Vergangenheit zurückzuverfolgen. Da wir die Gesetze kennen, die das Verhalten der Materie bei solchen Dichte und Temperaturverhältnissen beherrschen (siehe ZUSTANDSGLEICHUNG), können wir uns vorstellen, was in diesen fernen Zeiten geschehen sein könnte.

Daher suchen die Astrophvsiker in unserem heutigen Universum nach „fossilen“ Spuren der damaligen Ereignisse. Im Einzelnen ergibt sich für die Abfolge der Phänomene mit abnehmender Temperatur des Universums folgendes Bild: Zunächst entstanden die Elementarteilchen, die man als QUARKS bezeichnet, und aus ihnen wiederum Protonen und Neutronen; diese zerstrahlten gemeinsam mit ihren jeweiligen ANTITEILCHEN, so dass nur ein kleiner Rest an Nukleonen (unsere Materie) übrig blieb; diese Nukleonen verbanden sich dann zu Heliumkernen und anderen leichten chemischen Elementen (siehe ENTSTEHUNG DER ELEMENTE); und schließlich bildete sich der Wasserstoff, das im heutigen Universum häufigste Element, aus der Verbindung der restlichen Protonen und Elektronen.

Aber was geschah vor alledem? Dass die Dichte im Universum heute ausgerechnet einen Wert hat, der praktisch der kritischen Dichte entspricht, stört die Physiker, die das Allgemeingültige lieben und Zufälle hassen. Daher haben sie einen Mechanismus erdacht, der unmittelbar vor den oben beschriebenen Phasen abgelaufen sein soll und das Universum, wie immer es beschaffen gewesen mag, unter möglichst vielen denkbaren Umstünden doch stets auf den Weg zu seinem heutigen Zustand gebracht haben könnte, also genau an die Grenze zwischen einem »offenen« und einem »geschlossenen« Universum. Dieser Mechanismus ist eine extrem starke Expansion, die als INFLATION bezeichnet wird.

Und was war davor? Mit der Inflation erreichen wir die Grenzen der Physik, auf der das Standardmodell aufbaut. Von entscheidender Bedeutung ist dabei das Bild, das die Physik sich von der Gravitation in einem Zustand der Materie und der Energie machen, in dem der quantenphysikalische Charakter der an der gravitativen Wechselwirkung beteiligten Austauschprozesse nicht mehr vernachlässigt werden kann (siehe QUANTENPHYSIK).

Der Wert der kosmischen Zeit t, in der diese Situation eingetreten sein dürfte, ist unvorstellbar klein. Er liegt in der Größenordnung von 10-44 s [10 hoch minus 44 Sekunden] nach der Singularität (to) und wird als Planck-Zeit bezeichnet (siehe GRAVITATION). Über alles, was davor geschehen sein mag, wem das Modell nichts zu sagen.

aus Thesaurus der exakten Wissenschaften, Verlag Zweitausendeins

Felder, der dritte von vieren

man lese zuerst

Morphische Felder bei Wikipedia

Vorsicht!! Der nachfolgende Artikel beschreibt eine wissenschaftliche Hypothese, die in weiten Teilen (Formbildung) widerlegt wurde. Diejenigen Aussagen, die bisher nicht widerlegt wurden (im weitesten Sinne Informationsvermittlung, u. a. Telepathie) harren seit über 25 Jahren ihres Nachweises. Siehe dazu auch eine aktuelle Meldung von Mitte Mai 2008 bei Grenzwissenschaft-aktuell.

Rupert Sheldrake

Die kürzeste Beschreibung, die sich mir zu Rupert Sheldrake aufdrängt: er ist ganz außerordentlich englisch. Zwar entspricht der jungenhafte, schlaksige Biologe überhaupt nicht unserem Klischee vom steifen Briten – aber sein makelloser Public-School-Akzent, das understatement seiner Formulierungen und seine Fähigkeit, auch ziemlich boshafte Aussagen noch mit untadeliger Höflichkeit zum Ausdruck zu bringen, lassen doch nie das Land seiner Herkunft vergessen.

Rupert Sheldrake studierte Philosophie in Harvard und Naturwissenschaften in Cambridge, wo er 1973 in Biochemie und Zellbiologie promovierte. 1974 ging er zum „International Crops Research Institute“ nach Indien, wo er noch heute einen Teil des Jahres arbeitet.

Sheldrakes Auffassungen, die sich radikaler vom dominierenden Wissenschafts-Paradigma abwenden als manch lautstarke Kritik, haben ein starkes Echo gefunden und werden in Deutschland bereits ausgeibig zitiert. Dabei ist interessant, von wem, anders als zum Beispiel bei Bohm und Capra, wo meist Parallelen zur Mystik gezogen werden, scheint Sheldrake öfter von magisch orientierten Menschen als Bundesgenosse angerufen zu werden. Das ist kein Wunder; denn die Vorstellung von nicht-materiellen Konfigurationen, die über Zeit und Raum hinweg wirken, ist die Grundannahme jedes magischen Systems.

Sheldrake ist sich dieser Ähnlichkeit durchaus bewußt, aber ihm steht der Sinn nach handfester, altmodischer Empirie. Er möchte mit Hilfe von sauber durchgeführten Experimenten Daten sammeln, die es erlauben, seine Hypothesen zu bestätigen oder zu widerlegen. Dafür ist sogar ein für jedermann offener Wettbewerb ausgeschrieben worden, bei dem vielversprechende Vorschläge eingingen. Die Versuche sind im Gange.

DIE THEORIE DER MORPHOGENETISCHEN FELDER

Vortrag von Rupert Sheldrake

[auf dem Kongreß »Andere Wirklichkeiten«, 1983 in Alpbach, Österreich, Hinweis von mir]

übersetzt von Rainer Kakuska

Das mechanistische Paradigma, über das wir schon einiges gehört haben, ist in der Wissenschaft lange Zeit bestimmend gewesen. Und ein Aspekt dieses Paradigmas ist die Vorstellung, daß das Universum bestimmten Gesetzen folgt und daß diese Gesetze unwandelbar und zeitlos sind. Wenn wir von diesem Paradigma zu einem organischen Paradigma übergehen, so können wir das Universum ähnlich wie einen Organismus, der sich weiterentwickelt, betrachten. Und anstatt die Naturgesetze für festgelegt, für alle Zeiten wahr, unwandelbar zu halten, könnten wir sie mehr als Gewohnheiten auffassen. Dies sind einige Implikationen der Anschauungen, die ich gleich darlegen werde, der „Hypothese der formbildenden Verursachung“ (hypothesis of formative causation).

Um zu erklären, wie diese Sichtweise möglich ist, und worin sie genau besteht, ist es am besten, bei den Problemen zu beginnen, bei denen die Theorie ansetzt. Diese Probleme sind von zentraler Bedeutung für die Biologie. Obwohl die Theorie viele Implikationen in anderen Gebieten, unter anderem der Parapsychologie, hat, nimmt sie ihren Ausgangspunkt nicht von den dort untersuchten Fragen, sondern von zentralen Problemen der Biologie.

Eines der grundlegenden Probleme der Biologie, unseres Verständnisses von Tieren und Pflanzen, besteht darin, zu verstehen, wie Tiere und Pflanzen eigentlich ihre Form annehmen, ihre Gestalt. Wenn wir eine Blume betrachten, ein Blatt, eine Katze, ein Kaninchen, so sehen wir eine definitive Gestalt oder Form, und innerhalb dieser Formen von Tieren und Pflanzen sind wieder viele Formen, die Form der Organe, der Gewebe, der Zellen dieses Gewebes, und innerhalb dieser Zellen Organellen und Moleküle von komplizierter Gestalt. Wie kommen diese Formen zustande?

Ein Organismus entwickelt sich aus einem befruchteten Ei, das sehr wenig Struktur aufweist; während er sich weiterentwickelt, bildet sich mehr und mehr Struktur heraus. Diesen Prozeß der Entstehung von Form nennen die Biologen „Morphogenese“ vom Griechischen „morphe“, Form, und „genesis“ Entstehung. Obwohl die Morphogenese ein absolut grundlegendes Phänomen ist – jeder von uns sieht jeden Tag Pflanzen und Bäume und andere Menschen, wir erkennen all diese Formen, wir nehmen es als gegeben hin, daß aus Samen Bäume oder Blumen entstehen – obwohl dies also so ist, müssen wir uns in Erinnerung rufen, daß dieser für uns so selbstverständliche Vorgang wissenschaftlich überhaupt nicht verstanden wird.

In der Biologie wird unter dem herrschenden Paradigma, der mechanistischen Theorie des Lebens, der Versuch gemacht, den Prozeß der Entstehung von Form auf der Ebene der Moleküle und durch Betrachtung von bekannten chemischen und physikalischen Interaktionen zu erklären. Tatsächlich haben wir auch sehr viel über die Moleküle des Lebens herausgefunden, etwa über die genetische Substanz DNS (Desoxyribonucleinsäure) und die vielen Arten von Proteinen, aus denen lebende Organismen bestehen. Aber diese Entdeckungen der Biologie haben nicht zu einem Verständnis der Entstehung von Form geführt. Sie haben uns eine sehr detaillierte Kenntnis dessen vermittelt, was geschieht, wenn Form entsteht, aber sie haben den Vorgang selbst nicht geklärt. Wir können uns dieses Problem klarmachen, indem wir an unsere Körper denken.

Die DNS in all unseren Körperzellen ist die gleiche. Wir haben identische Kopien allen genetischen Materials in allen Zellen. Trotzdem ist die Form unserer Arme und Beine verschieden voneinander. Unsere Arme wie unsere Beine enthalten die gleichen Proteine, die gleichen Muskelproteine, Nervenproteine, Blutproteine, usw. Aber mit der gleichen chemischen Zusammensetzung entstehen doch verschiedene Formen. Natürlich enthalten verschiedene Organe wie das Auge oder das Ohr oder die Leber oder die Nieren auch verschiedene Chemikalien, das Problem ist nur, daß die chemischen Substanzen alleine die Form noch nicht erklären. Es ist wie in der Architektur: Wenn wir Häuser oder Gebäude untersuchen, werden wir die Form des Gebäudes nicht dadurch verstehen, daß wir die Ziegel, den Mörtel oder das Holz analysieren, die in dem Gebäude verarbeitet wurden. Die gleichen Ziegel, der gleiche Mörtel, das gleiche Holz können Gebäude von verschiedener Form ergeben. Also wird die Form des Gebäudes nicht durch die chemische Zusammensetzung der Substanzen erklärt, aus denen es besteht.

Angesichts dieses Problems ist von Biologen, speziell von Embryologen und Entwicklungs-Biologen ein Konzept entwickelt worden, um die Morphogenese zu verstehen, nämlich das der „morphogenetischen Felder“. Dieses Konzept ist das erste Mal 1922 formuliert worden, und es ist der Gedanke, daß ein Organismus bei seinem Wachstum von formgebenden Feldern beeinflußt wird. Die Vorstellung dieser Felder ist zunächst in Analogie mit bekannten Feldern der Physik, wie zum Beispiel dem magnetischen Feld, entstanden. Um einen Magneten herum existiert ein Feld, das man weder sehen noch berühren noch riechen oder schmecken oder hören kann. Aber wir können seine Existenz dadurch offenkundig machen, daß wir Eisenspäne um den Magnet herum streuen: Dann sehen wir ein Muster, das uns etwas über das Feld um den Magneten verrät. Der Gedanke war nun, daß ebenso wie Magneten von Feldern umgeben sind – auch Organismen unsichtbare Felder haben, die ihre Entwicklung steuern und ihre Form bestimmen, wie eine unsichtbare Gußform. Danach tritt also das befruchtete Ei des Organismus mit den morphogenetischen Feldern seiner Spezies in Verbindung, dieses Feld beeinflußt die Entwicklung des Embryos, dann formen untergeordnete Felder die Arme und Beine, und innerhalb dieser Felder formen andere Felder wiederum die Finger, die Fußnägel, die Knochen, usw. Bei der Entwicklung des Organismus ist also eine ganze Hierarchie von formgebenden Feldern am Werk.

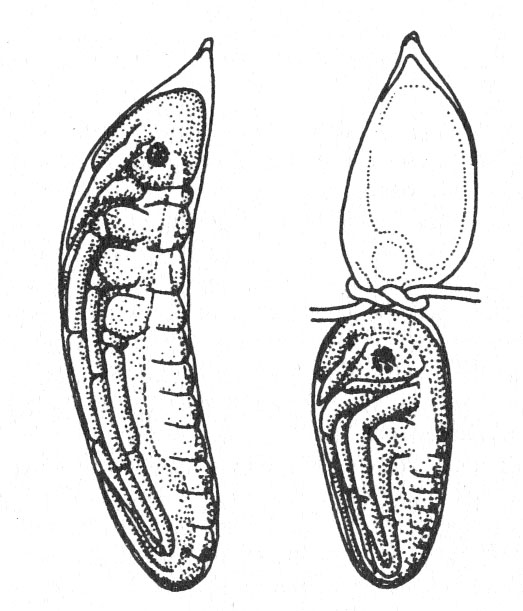

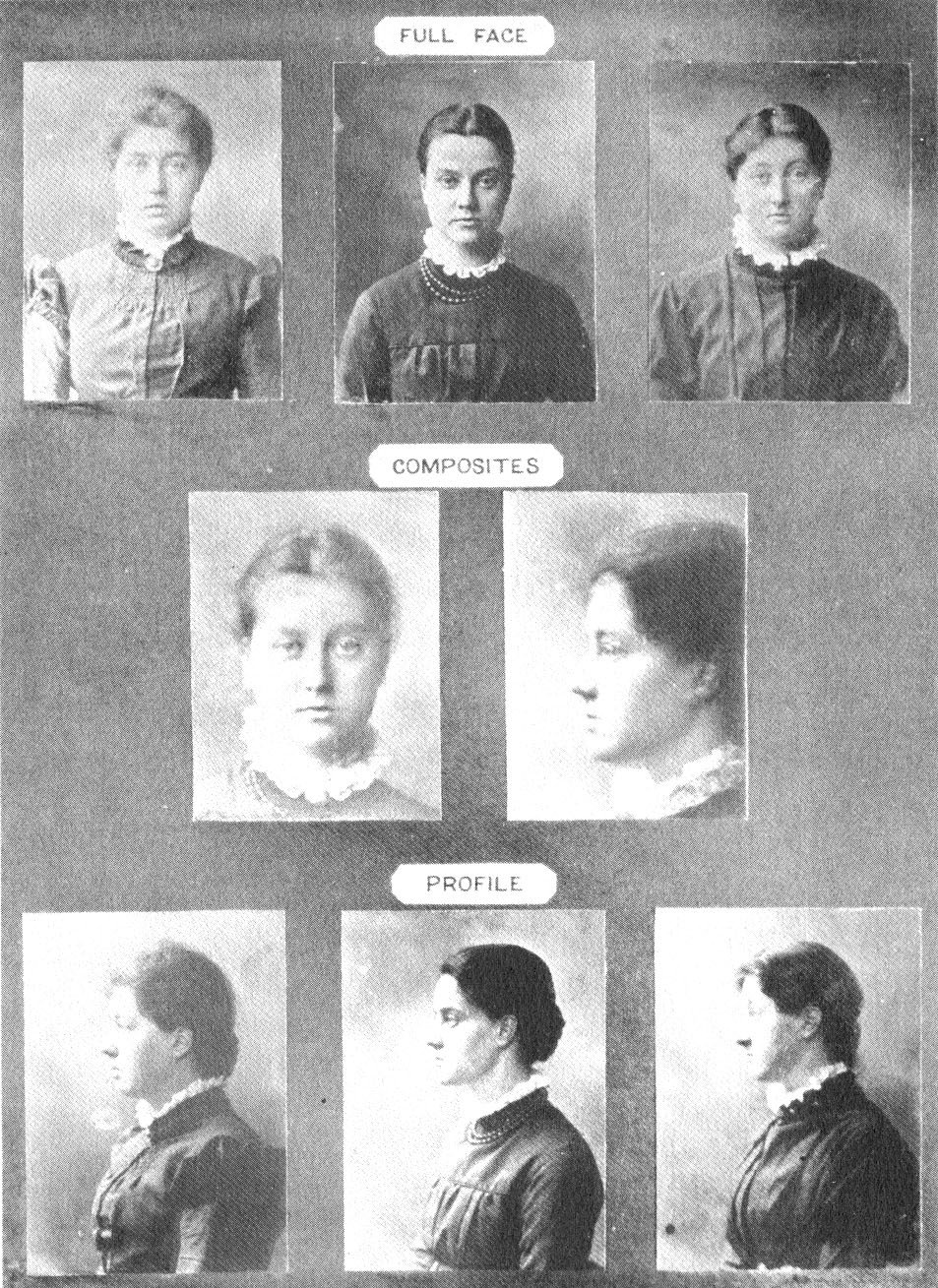

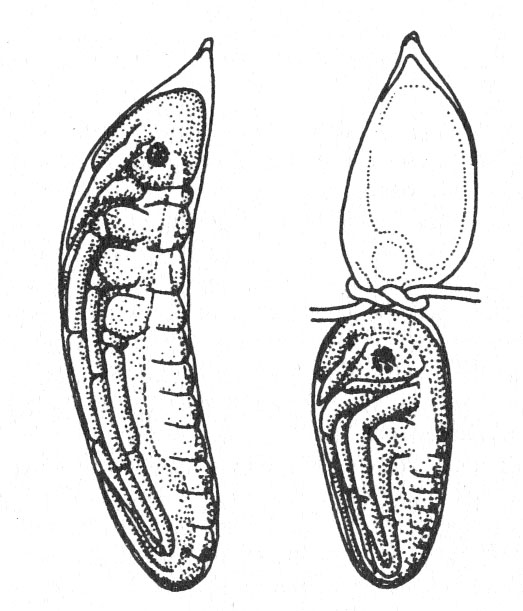

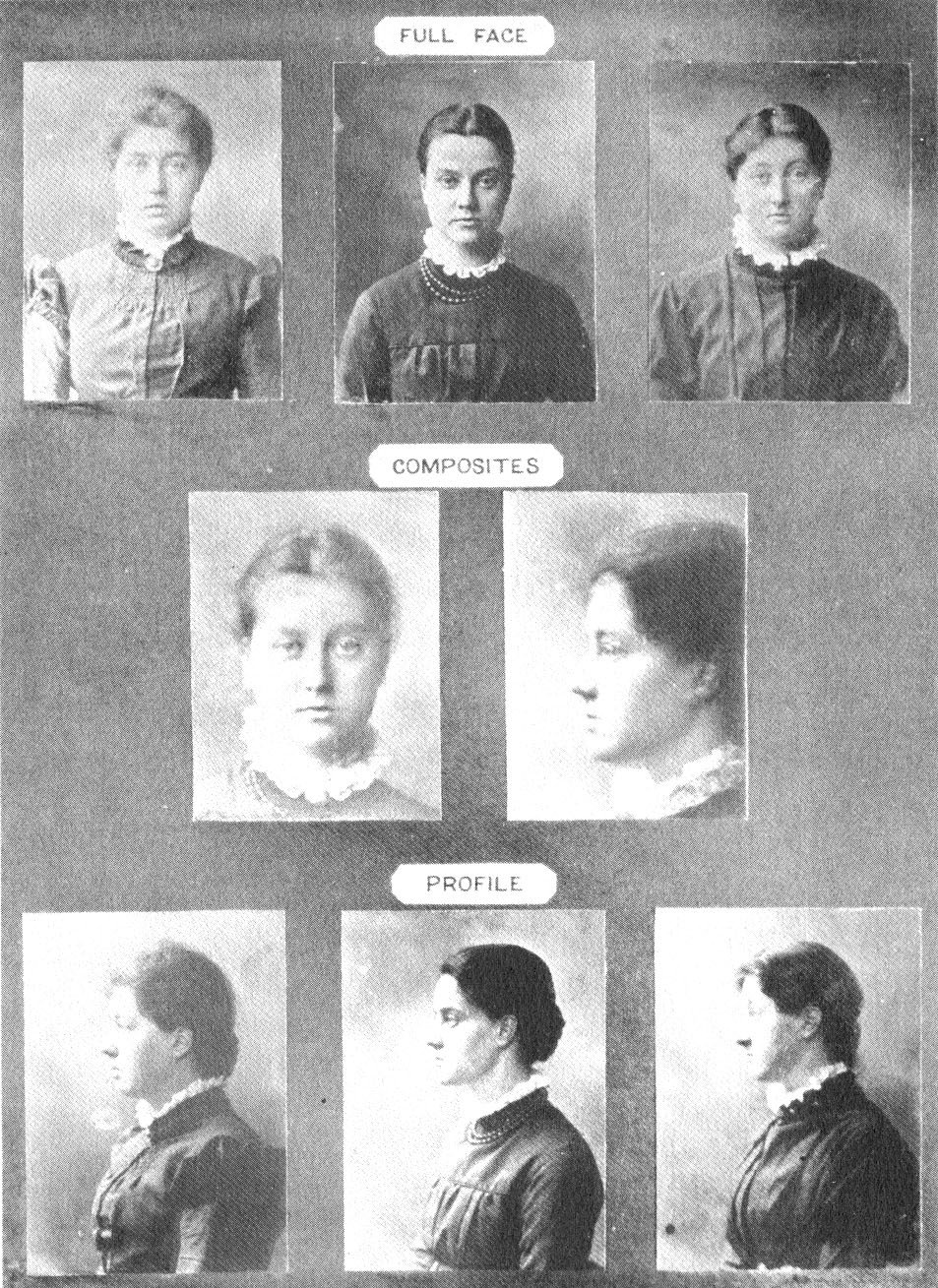

Dieses Konzept half, einige der entscheidenden Probleme der Embryologie zu verstehen, wie ich anhand der folgenden Abbildung illustrieren kann:

Wir sehen hier links das normale Ei einer Libelle, in dem sich der Embryo entwickelt hat. Rechts ist das Ei mit einem dünnen Faden abgebunden worden, wodurch ein Teil von ihm abgestorben ist, es ist also nur noch die eine Hälfte des Eis übrig, die hintere. Aus ihm entsteht aber nun nicht nur die hintere Hälfte des Embryos, wie das beim normalen Ei der Fall gewesen wäre, sondern stattdessen ein zwar kleinerer, aber vollständigerer Embryo. Also bekommen wir aus einem Teil des Eis den ganzen Organismus. Irgendwie war der Organismus imstande, mit der Beschädigung fertig zu werden und trotzdem ein Ganzes auszubilden. In der nächsten Abbildung sehen wir ein anderes Beispiel für diese Art von Prozeß:

Hier handelt es sich um Regeneration. Jeder kennt die Regeneration bei Pflanzen. Wir können einen kleinen Teil einer Pflanze abschneiden, ihn in Erde geben, und wenn wir Glück haben, wird er zu einer Pflanze werden. Aus einem Baum kann man Tausende von Bäumen machen, von denen jeder aus einem kleinen Teil des Baumes entsteht. Der Teil kann also ein neues Ganzes hervorbringen. Dies ist einer der Gründe für die Annahme in der Biologie, daß das Ganze mehr ist als die Summe seiner Teile, weil wir Teile entfernen können und das Ganze bleibt erhalten, und weil aus Teilen selbst ein Ganzes werden kann. Das ist eine sehr mysteriöse Eigenschaft, die die Biologen lange Zeit in Staunen versetzt hat, und es ist eines der Probleme, mit denen sich jede biologische Theorie auseinandersetzen muß.

Hier handelt es sich um Regeneration. Jeder kennt die Regeneration bei Pflanzen. Wir können einen kleinen Teil einer Pflanze abschneiden, ihn in Erde geben, und wenn wir Glück haben, wird er zu einer Pflanze werden. Aus einem Baum kann man Tausende von Bäumen machen, von denen jeder aus einem kleinen Teil des Baumes entsteht. Der Teil kann also ein neues Ganzes hervorbringen. Dies ist einer der Gründe für die Annahme in der Biologie, daß das Ganze mehr ist als die Summe seiner Teile, weil wir Teile entfernen können und das Ganze bleibt erhalten, und weil aus Teilen selbst ein Ganzes werden kann. Das ist eine sehr mysteriöse Eigenschaft, die die Biologen lange Zeit in Staunen versetzt hat, und es ist eines der Probleme, mit denen sich jede biologische Theorie auseinandersetzen muß.

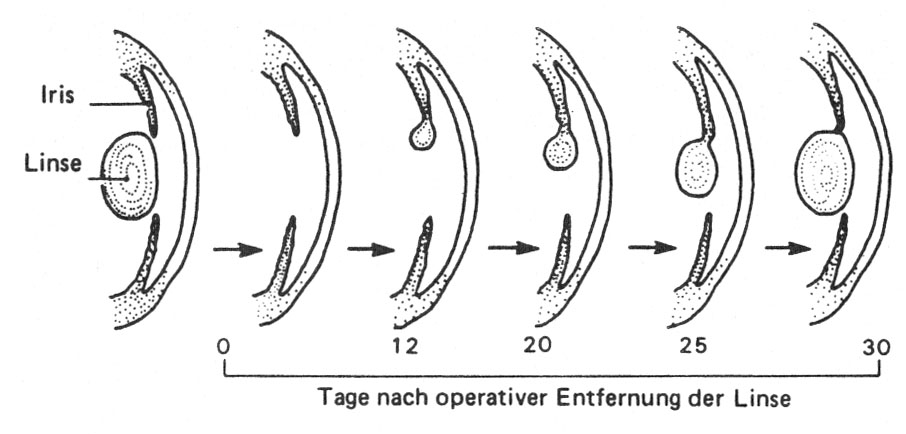

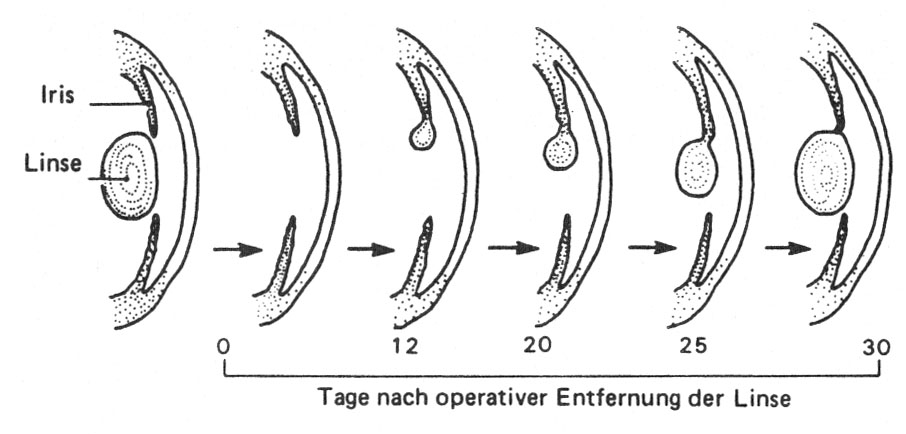

Die Abbildung zeigt nun ein Beispiel für Regeneration bei einem Tier, einem Wassermolch. Wir sehen, was geschieht, wenn man in seinem Auge die Linse entfernt: Es bildet sich eine neue Linse vom Rand der Iris her. Mit anderen Worten, die Linse wird regeneriert und das Auge erreicht wieder den Zustand der Ganzheit, nach Entfernung eines Teils. Im normalen Embryo entsteht die Linse auf ganz andere Weise, nicht vom Rand der Iris her, sondern dadurch, daß sich die äußere Haut des Embryos einfaltet. Auch ist die hier gezeigte Beschädigung von einer Art, wie sie in der Natur nie vorkommt, schließlich gehen dort nicht experimentelle Zoologen mit dem Skalpell um, die Linsen herausschneiden. Hier haben wir also ein eindrucksvolles Beispiel von Regeneration, und es gibt Tausende von anderen: Man kann zum Beispiel Plattwürmer in kleine Teile zerschneiden und aus jedem wird ein neuer Wurm entstehen.

Der Begriff der morphogenetischen Felder ist entwickelt worden, um diesen Vorgang zu verstehen. Der Grundgedanke ist dabei, daß das Feld dem System zugehörig ist, das man beschädigt, und daß Regeneration deswegen möglich ist, weil das Feld immer noch da ist und das System zu seiner eigentlichen Form, der ganzen Form, führen kann, obwohl man einen Teil davon weggenommen hat. Und eine der Eigenschaften von Feldern ist ihre Geschlossenheit. Denken Sie wieder an den Vergleich mit dem Magneten: Wenn man einen Magneten in zwei Hälften schneidet, erhält man nicht zwei halbe Magneten, sondern zwei ganze, kleiner, aber trotzdem vollständig. Und jeder ganze Magnet hat ein vollständiges magnetisches Feld um sich herum. Man kann nicht eine Scheibe aus dem Feld herausschneiden und wegtragen. Das Feld ist eine Ganzheit Genau das ist die Idee hinter dem Konzept der morphogenetischen Felder: daß sie form-gebende Ganzheiten sind.

Dieser Gedanke ist das erste mal 1922 formuliert worden, von dem Russen Alexander Gurwitsch, und er wurde dann in den 20er Jahren in Österreich von Paul Kammerer weiterentwickelt. Seither allerdings hat sich die Theorie nicht mehr sehr verändert. Viele Biologen haben den Gedanken akzeptiert und den Begriff der morphogenetischen Felder verwendet, aber die Frage, was die Felder nun eigentlich sind und wie sie funktionieren, blieb ziemlich im Dunkeln. Viele Biologen sagen: Der Begriff des morphogenetischen Feldes ist eben eine Art, über komplizierte physikalische und chemische Interaktionen zu reden, die wir noch nicht ganz verstehen. Das läuft dann aber mehr oder weniger auf eine mechanistische Sichtweise hinaus, besagt das gleiche wie das herkömmliche mechanistische Modell. Dadurch ist also eine Ansicht, die ursprünglich als radikale Abkehr von der orthodoxen Biologie begonnen hat, für die meisten Leute wieder zu einem Teil der orthodoxen Auffassung geworden, daß man nämlich irgendwann alles in Begriffen von Molekülen, Elektrizität und anderen bekannten physikalischen Faktoren verstehen können wird.

Andere sind der Ansicht, daß es mit den morphogenetischen Feldern mehr auf sich hat, und einige Wissenschaftler vertreten sogar ausdrücklich den Standpunkt, daß es sich dabei um Platonische Ideen oder Archetypen handelt, um sozusagen metaphysische Realitäten, die idealen, zeitlosen Formen aller Lebewesen. Nicht viele Biologen vertreten diese Ansicht, aber doch einige; und meistens tun sie das nicht öffentlich. Immerhin gibt es manche, die diesen Standpunkt sehr leidenschaftlich verfechten.

Die Theorie, die ich hier darlegen werde, ist davon sehr verschieden. Was ich bisher gesagt habe, diente dazu, Ihnen den Hintergrund für die Hypothese zu geben, die ich darstellen will. Bis jetzt habe ich einige Entwicklungen der Biologie in den letzten 60 Jahren zusammengefaßt. Meine eigene Hypothese stellt eine dritte Art, über morphogenetische Felder zu denken, dar. Ich nehme an, daß diese Felder wirklich existieren, daß sie nicht einfach magnetische oder elektrische Felder sind, nicht einfach eine Umschreibung für bekannte Arten von Interaktionen zwischen den Teilen eines Organismus; sondern daß wir es hier mit einer neuen Art von Feld zu tun haben, das von der Wissenschaft bisher noch nicht in Betracht gezogen wurde. Außerdem nehme ich an, daß diese Felder eine bestimmte Form haben, daß also zum Beispiel das Feld einer Rose sozusagen rosenförmig ist, oder das Feld eines Hundes in einer direkten Beziehung zur Form des Hundes steht. Und es muß sehr, sehr viele verschiedene Felder für alle verschiedenen Arten von Tieren und Pflanzen geben. Wenn jedes dieser Felder dem sich entwickelnden Organismus seine spezifische Gestalt verleiht, so muß das Feld dieser bestimmten Spezies selbst eine spezifische Form oder Struktur haben.

Wie erhält es diese Struktur? Die Antwort, die ich vorschlage, ist, daß sich die Struktur eines morphogenetischen Feldes aus der tatsächlichen Form früherer Mitglieder dieser Spezies herleitet. Das Feld, das etwa einer Katze ihre Form gibt, das katzen-morphogenetische Feld sozusagen, ist dann eine Art Zusammenfassung (composite) der tatsächlichen Formen früherer Katzen. Deren Form beeinflußt die sich entwickelnde Katze durch Fernwirkung (action at a distance) über Zeit und kaum hinweg, nicht dadurch, daß sie in der DNS verschlüsselt ist. Dieses morphogenetische Feld stellt dann so etwas wie das Gedächtnis der Art dar, ein kollektives oder zusammengefaßtes Gedächtnis. Jedes Mitglied einer Spezies wird durch deren spezifisches morphogenetisches Feld geformt, das Feld der Spezies. Umgekehrt beeinflußt aber die Form, die der Organismus schließlich entwickelt, wiederum das morphogenetische Feld, wirkt auf dieses Feld zurück und formt dadurch zukünftige Mitglieder derselben Art.

Das sind keine leicht zu verstehenden Gedankengänge, weil sie sehr verschieden von den Ideen sind, mit denen wir aufgewachsen sind. Ich werde sie im Folgenden ausführlicher erklären, Beispiele dafür geben und auch zeigen, wie sie überprüft werden könnten.

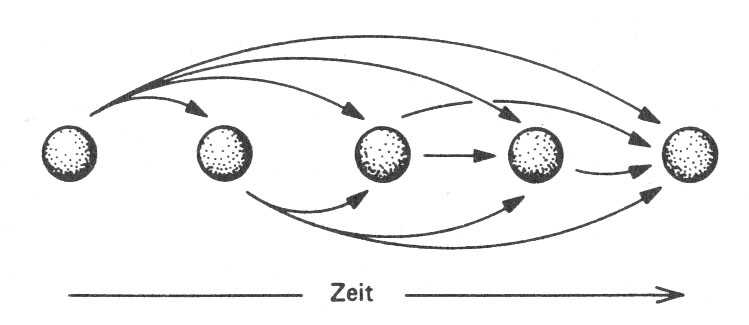

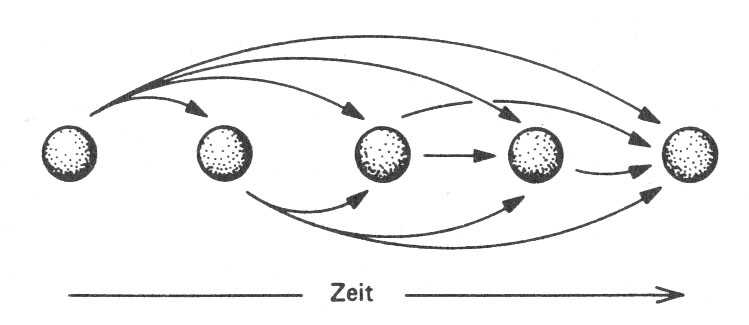

Dieses Diagramm zeigt in einer sehr vereinfachten Weise, wie sich der Einfluß solcher Felder über die Zeit aufbaut. Jede Form, jede Art von Tier oder Pflanze entsteht in der Zeit, und es gibt immer ein erstes dieser Art. Meine Theorie sagt nun nichts darüber aus, wie dieses erste Exemplar zustande kommt; darauf werden wir später noch zu sprechen kommen. Worüber meine Theorie Aussagen macht ist, wie diese Struktur, wenn sie erst einmal entstanden ist, wiederholt wird, wie sie dazu neigen wird, immer wieder vorzukommen. Wenn eine bestimmte Struktur das zweite Mal entsteht, wird sie vom ersten Exemplar beeinflußt werden, beim dritten Mal vom ersten und zweiten, beim vierten Mal vom ersten, zweiten und dritten usw. Der Einfluß wird also kumulativ sein. Ich behaupte, daß dieser Einfluß nicht mit der Zeit verschwindet, und daß er auch durch Raum oder Entfernung nicht abgeschwächt wird. Wenn also die Anzahl von Mitgliedern einer Spezies wächst, wird das morphogenetische Feld stärker werden, durch Wiederholung intensiviert. Je öfter etwas Bestimmtes passiert, desto wahrscheinlicher wird es wieder passieren.

Dieses Diagramm zeigt in einer sehr vereinfachten Weise, wie sich der Einfluß solcher Felder über die Zeit aufbaut. Jede Form, jede Art von Tier oder Pflanze entsteht in der Zeit, und es gibt immer ein erstes dieser Art. Meine Theorie sagt nun nichts darüber aus, wie dieses erste Exemplar zustande kommt; darauf werden wir später noch zu sprechen kommen. Worüber meine Theorie Aussagen macht ist, wie diese Struktur, wenn sie erst einmal entstanden ist, wiederholt wird, wie sie dazu neigen wird, immer wieder vorzukommen. Wenn eine bestimmte Struktur das zweite Mal entsteht, wird sie vom ersten Exemplar beeinflußt werden, beim dritten Mal vom ersten und zweiten, beim vierten Mal vom ersten, zweiten und dritten usw. Der Einfluß wird also kumulativ sein. Ich behaupte, daß dieser Einfluß nicht mit der Zeit verschwindet, und daß er auch durch Raum oder Entfernung nicht abgeschwächt wird. Wenn also die Anzahl von Mitgliedern einer Spezies wächst, wird das morphogenetische Feld stärker werden, durch Wiederholung intensiviert. Je öfter etwas Bestimmtes passiert, desto wahrscheinlicher wird es wieder passieren.

Da aber die Mitglieder einer Spezies einander nicht völlig gleichen, sondern nur ähnlich sind, wird das morphogenetische Feld, das ihren Einfluß repräsentiert, sozusagen eine Zusammenfassung der früheren Mitglieder der Spezies sein. Es wird nicht eine definitive Form ergeben, nicht scharf abgegrenzt sein, sondern mehr eine Wahrscheinlichkeitsstrukur darstellen. Eine Analogie für diesen Prozeß findet sich bei „kumulativen Fotografien“ (composite photographs).

Diese Fotografien wurden vor 100 Jahren von Francis Galton angefertigt, einem Cousin von Charles Darwin, der an durchschnittlichen Formen interessiert war. In der oberen Reihe sehen Sie drei Schwestern, in der unteren Reihe diese Schwestern im Profil. Die mittlere Reihe zeigt „durchschnittliche Schwestern“, die dadurch entstehen, daß man die Bilder der drei auf den selben Film aufgenommen hat, mit einem Drittel der Belichtungszeit für jede einzelne Aufnahme. Das ist jetzt der Durchschnitt von nur dreien, aber man kann den Vorgang weiterführen, und was dabei herauskommt, zeigt das nächste Bild.

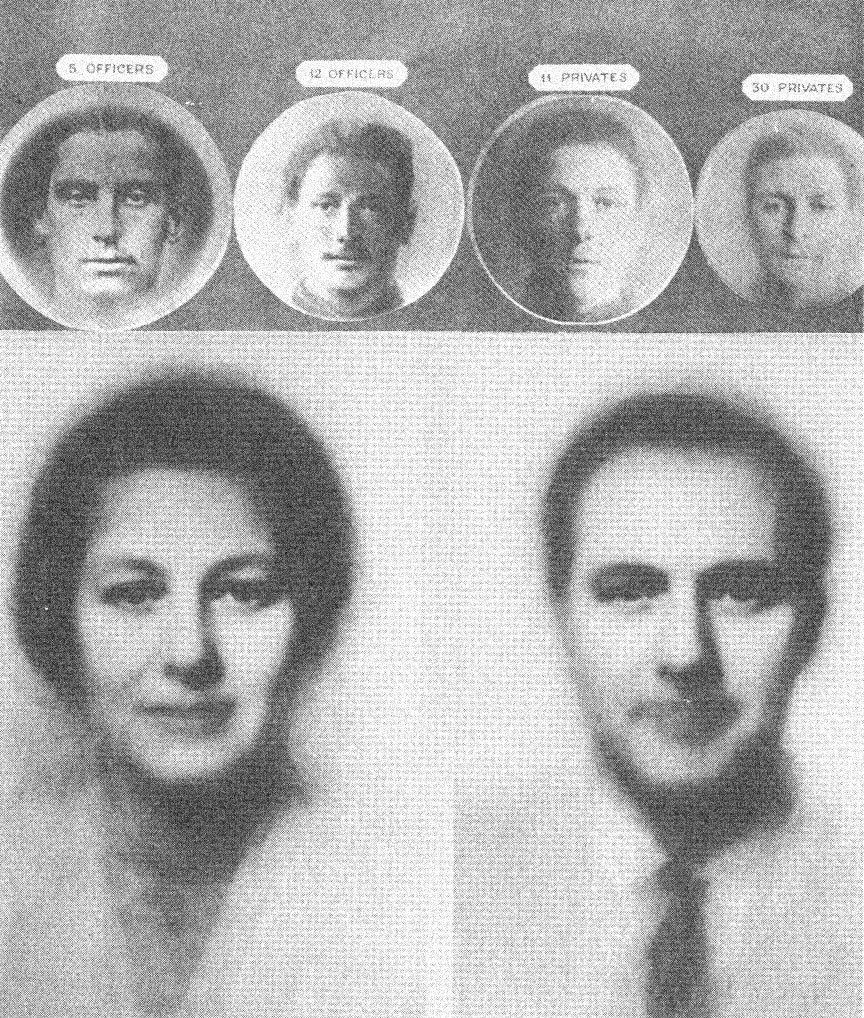

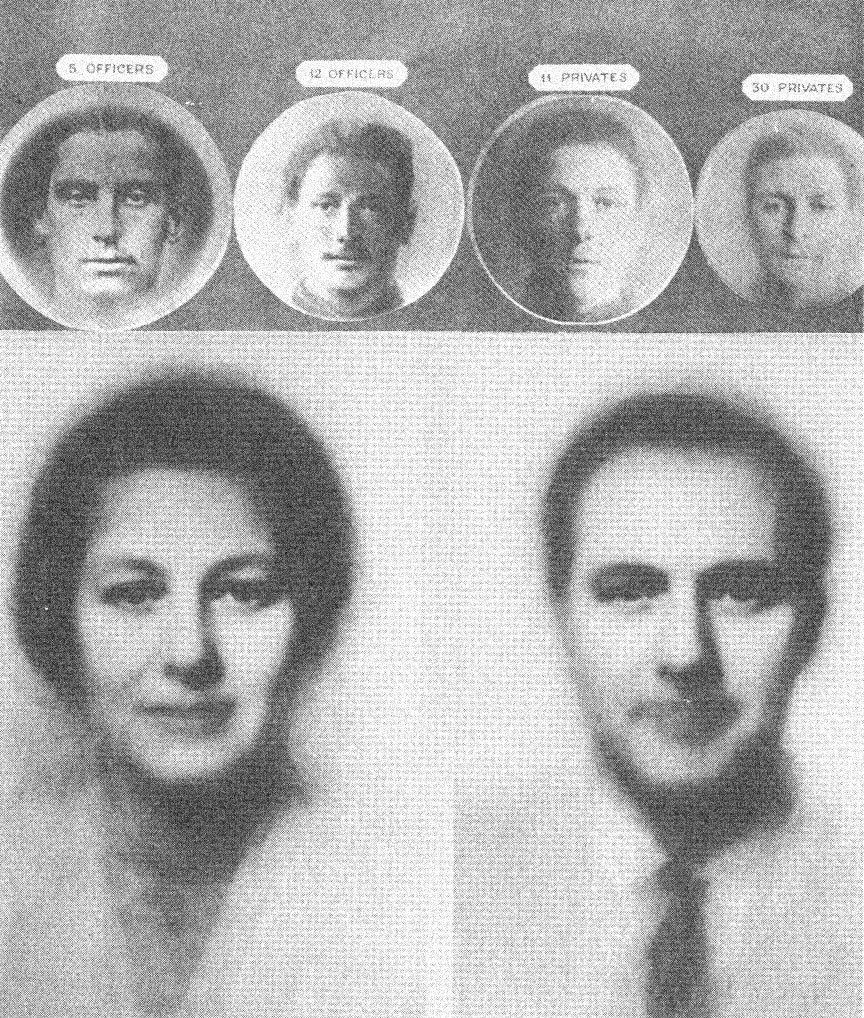

Oben haben wir Beispiele von durchschnittlichen Offizieren, links, und durchschnittlichen Mannschaftsgraden, rechts, der Britischen Armee. Francis Galton war sehr daran interessiert, herauszufinden, ob Offiziere einem bestimmten rassischen Typ angehörten; das interessierte damals viele Engländer.

Oben haben wir Beispiele von durchschnittlichen Offizieren, links, und durchschnittlichen Mannschaftsgraden, rechts, der Britischen Armee. Francis Galton war sehr daran interessiert, herauszufinden, ob Offiziere einem bestimmten rassischen Typ angehörten; das interessierte damals viele Engländer.

Der Hauptunterschied scheint aber gewesen zu sein, daß mehr Offiziere Schnurrbärte hatten. In der unteren Reihe sehen sie moderne kumulative Fotografien, links 30 weibliche und rechts 45 männliche Wissenschaftler vom John Innes Research Institute in England.

Wenn Sie also das Gesicht rechts ansehen, sehen Sie in Wirklichkeit 45 männliche Gesichter. Die individuellen Unterschiede heben einander auf, die gemeinsamen Züge werden verstärkt. Und die Form des Gesichts ist durch die Wahrscheinlichkeitsverteilung bestimmt, die wir auf diese Weise bekommen. Könnte man morphogenetische Felder sehen, ich glaube, sie würden so aussehen: sie hätten unscharfe Ränder, wären nicht klar abgegrenzt, sie wirken im Sinne von Wahrscheinlichkeit, nicht exakter Kausalität. Und das ist wichtig, weil ich glaube, daß sie letztlich probabilistische Prozesse auf der Quantenebene beeinflussen, wie sie die moderne Physik beschreibt.

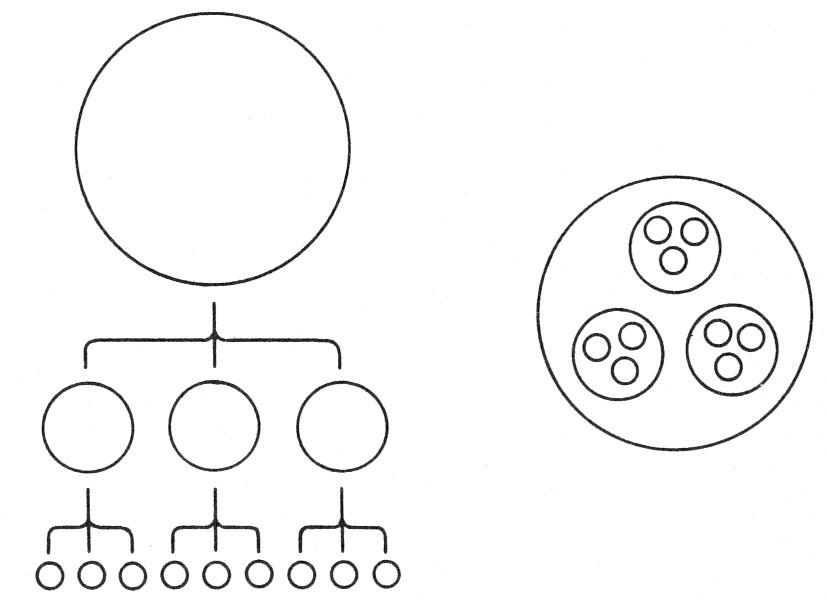

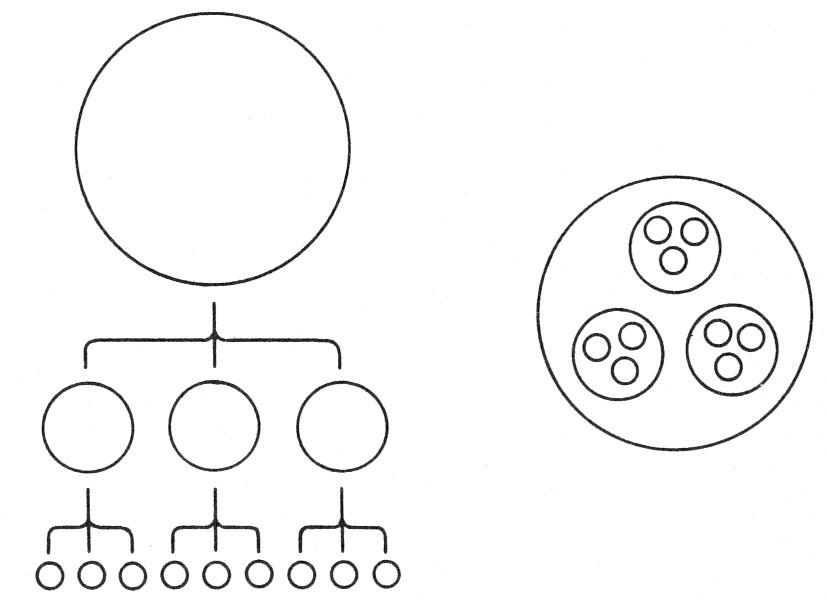

Die nächste Abbildung zeigt, wie morphogenetische Felder aufgebaut sind.

Die nächste Abbildung zeigt, wie morphogenetische Felder aufgebaut sind.

Links haben wir das übliche Diagramm einer Hierarchie, rechts ist eine bessere Darstellung des gleichen Zusammenhanges, die wir „eingebettete Hierarchie“ (nested hierarchy) nennen könnten, denn sie zeigt, wie jedes Organisationsniveau in das nächsthöhere eingebettet ist. Wir könnten uns den äußersten Kreis zum Beispiel als den Organismus denken, die kleineren Kreise stellten dann die Organe dar, die Kreise darin die Gewebe, darin wären dann die Zellen, die Organellen, Proteinmoleküle usw. bis hin zu den Atomen und subatomaren Partikel. Morphogenetische Felder schließen also andere morphogenetische Felder ein, und ich glaube, sie wirken auf Systeme dadurch ein, daß sie die Felder und die Wahrscheinlichkeit der Ereignisse auf den niedrigeren Oranisationsniveaus beeinflussen. Wie das funktionieren könnte, kann ich hier nicht näher ausführen, ich gehe darauf detaillierter in meinem Buch ein.

Nun muß ich auf die Frage zu sprechen kommen, was diese Theorie tatsächlich bedeutet. Bisher habe ich darüber in einer sehr abstrakten und theoretischen Weise gesprochen, und tatsächlich ist es ja nur eine Theorie, eine Weise, die Welt zu betrachten. Aber in der Wissenschaft ist es wichtig zu sehen, was die Konsequenzen einer bestimmten Theorie sind, und herauszufinden, ob diese Folgerungen überprüft werden können. Und um das zu tun, müssen wir Voraussagen treffen und dann Experimente entwickeln, die diese Voraussagen prüfen. Ich werde jetzt einige derartige Experimente beschreiben.

Zunächst betrifft diese Theorie nicht nur lebende Organismen. Sie gilt auch für die Formen von Kristallen, Molekülen und Atomen. Ich behaupte, daß diese Art von Feldern sogar im chemischen Bereich wirken. Denken wir zum Beispiel an die Form eines Kristalls, genauer an die Gitterstruktur, also die Art, wie die Moleküle angeordnet sind: es gibt Gründe für die Annahme, daß diese Form nicht allein durch bekannte energetische Zusammenhänge verursacht ist. Wenn ein neuer Stoff hergestellt wird, den es bisher noch nie gegeben hat – in der Pharmazie, in anderen Bereichen der chemischen Industrie und in Universitäten geschieht das ständig – so wird zunächst kein morphogenetisches Feld für die Kristallstruktur bestehen, weil diese Art von Kristall noch nie existiert hat. Es könnte also das erste Mal schwierig sein, die Substanz zu kristallisieren, wir müßten waren, bis ein morphogenetisches Feld entsteht, wie immer das auch geschieht. Aber nachdem die Substanz einmal Kristalle gebildet hat, sollte es beim zweiten Mal überall auf der Welt schon ein wenig leichter sein, weil der Vorgang vom morphogenetischen Feld des ersten Kristalls beeinflußt würde. Beim dritten Mal wäre es dann wieder leichter, beim vierten Mal noch mehr – überall auf der Welt müßte es mit der Zeit leichter sein, die Substanz zu kristallisieren. Ist das tatsächlich so?

Die Antwort lautet: ja. Es ist den Chemikern wohlbekannt, daß neue Substanzen zunächst schwierig zu kristallisieren sind und daß es überall auf der Welt mit der Zeit leichter wird. Das ist unzählige Male beobachtet worden, viele Chemiker wissen es aus eigener Erfahrung, es ist eine unter Chemikern allgemein akzeptierte Tatsache. Aber wie lautet die Erklärung dafür? Eine mögliche Erklärung lautet, daß es ein Chemiker vom anderen lernt, und das ist natürlich möglich und sicher ein Faktor. Die andere Erklärung aber, zusätzlich zu verbesserten Methoden, ist eine höchst ungewöhnliche. Sie nimmt an, daß die Substanzen deswegen schneller kristallisieren, weil kleine Teile der Kristalle in der Kleidung und speziell in den Bärten von wandernden Chemikern in der ganzen Welt herumgetragen werden und dann in anderen Laboratorien aus ihren Bärten in die Kristallisierungsschalen fallen und solcherart die Kristallisation beschleunigen. Viele Chemiker werden Ihnen derartige Geschichten erzählen. Wenn Sie Freunde haben, die Chemiker sind, fragen Sie sie etwas zum Thema Kristallisation, aber sagen Sie nicht, warum Sie fragen. Machen Sie das Experiment, und ich garantiere Ihnen, in der Mehrzahl der Fälle werden Sie eine Geschichte über einen bärtigen Chemiker hören. Das gehört zur Folklore in der Chemie, es ist ein schwieriges Gebiet dieser Disziplin und wird in den Lehrbüchern nicht sehr systematisch behandelt, aber es existiert als eine Art Folklore in den Köpfen der Chemiker.

Aus dem Blickwinkel der Hypothese, die ich vorschlage, sind diese Vorgänge nun sehr interessant, weil hier die Fakten den Erwartungen der Hypothese entsprechen. Die bisherigen Erklärungen sind nicht gerade überzeugend und sind auch noch nie empirisch überprüft worden. Dabei wäre das leicht möglich: Man könnte versiegelte Behälter an verschiedenen Orten in der Welt aufstellen, um die Kristallisationsgeschwindigkeit zu verschiedenen Zeiten zu überprüfen. Man könnte bärtige Chemiker von den Experimenten ausschließen und Staubpartikel ausfiltern – eine andere Erklärung ist nämlich, daß winzige Partikel der Kristalle in die Luft gelangen und in mikroskopisch kleinen Staubteilchen über die ganze Welt verteilt werden. Dann könnte man prüfen, ob die Kristallisation in einer gesättigten Lösung unter Standardbedingungen wirklich mit der Zeit schneller vor sich geht. Das wäre ein möglicher Test, aber er ist noch nicht gemacht worden.

Es gibt viele mögliche Überprüfungen im Bereich von Form und der Vererbung von Form. Einige davon diskutierte ich in meinem Buch. Die Erklärung wäre aber hier zu kompliziert und würde den Rahmen dieses Vortrags sprengen.

Ich möchte jetzt darauf zu sprechen kommen, wie man die Theorie im Bereich des Verhaltens prüfen kann. Wir gehen also von einem Ende des Spektrums, den Kristallen, gleich zum anderen, dem Verhalten. Und ich glaube, daß die selben Prinzipien, die gleichen formativen Felder, auch das Verhalten beeinflussen. Ich behaupte, daß das ererbte Verhalten von Tieren, das heißt ihre Instinkte, durch die gleiche Art von Einfluß aus der Vergangenheit zustandekommen, durch jenen Prozeß der Einwirkung von Gleichem aus Gleichem, den ich „morphische Resonanz“ nenne. Dies sollte auch auf Verhalten zutreffen.

Eine der Vorhersagen der Theorie ist: Wenn man in einem Teil der Welt Tieren beibringt, etwas Neues zu tun, so sollte es dadurch überall in der Welt für Tiere leichter werden, die gleiche Sache schneller zu lernen. Wenn wir also hier in Österreich Ratten einen neuen Trick beibringen, dann sollten Ratten in New York oder Australien oder Afrika imstande sein, diesen Trick leichter zu lernen, nur weil wir die Ratten hier trainiert haben, ohne daß eine Kommunikation im üblichen Sinne stattgefunden hat. Also nicht weil wir per Telefon durchgegeben haben, wie man die Ratten trainiert, oder weil wir Ratten von hier nach dort gebracht hätten, die es den anderen Tieren vormachen. Ohne diese Art von Verbindung sollten sie schneller lernen, das ist die Vorhersage der Theorie. Daran sehen Sie, wie radikal diese Theorie ist und wie sehr sie sich von der gängigen mechanistischen Theorie der Biologie unterscheidet.

Wiederum ist dies etwas, was überprüft werden kann. Und tatsächlich ist es überprüft worden. Man hat das Verhalten von Ratten lange Zeit untersucht und beobachtet, mit welcher Geschwindigkeit sie neue Tricks lernen. Ich habe die umfangreiche Literatur über Rattenpsychologie durchgearbeitet, und tatsächlich scheint der Effekt, von dem ich spreche, eingetreten zu sein. Ich behaupte nicht, dies sei schon ein zwingender Beweis für die Theorie. Ich sage nur, wenn man nach Bestätigung sucht, findet man Dinge, die in diese Richtung weisen.

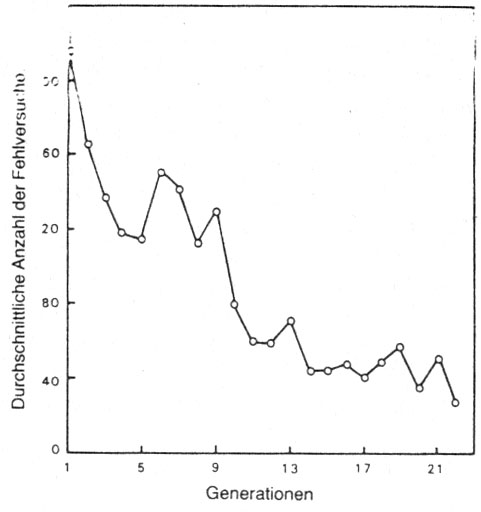

Ich gebe nur ein Beispiel für solche Ergebnisse aus Experimenten mit Ratten, die zwischen 1920 und 1954 durchgeführt wurden. Sie wurden von W. McDougall, einem Psychologieprofessor in Harvard, begonnen. Er brachte Ratten bei, aus einem Wasser-Labyrinth zu entkommen, und die erste Generation von Ratten lernte sehr langsam. Wenn die Tiere Fehler machten, bekamen sie unglücklicherweise einen elektrischen Schock verpaßt – das ist in dieser Art von Experimenten leider üblich. Viele von ihnen bekamen Hunderte von elektrischen Schocks, bis sie lernten, daß die den falschen Ausgang benutzten. McDougall ließ diese Ratten nun Nachkommen haben, und testete diese. Sie lernten schneller. Die nächste Generation ernte noch schneller. McDougall dachte, damit Beweise für die Vererbung von erworbenen Eigenschaften erbracht zu haben, für Lamarck’s Theorie der Vererbung, die hier in Österreich von Paul Kammerer verteidigt wurde und in den 20er Jahren eine sehr umstrittene Theorie war.

Die Experimente wurden von wissenschaftlichen Gegnern heftig kritisiert, und um diesen Einwänden zu begegnen, mußte McDougall seine experimentellen Techniken verbessern und die Versuche noch strikter kontrollieren. Es gelang ihm, die Kritik zu entkräften. Der am häufigsten vorgebrachte Einwand war der, er habe die intelligentesten Ratten zur Zucht bestimmt. Er sagte, das sei nicht der Fall gewesen, er habe die Ratten nach einem Zufallsprozeß ausgewählt, bevor sie die Eltern der nächsten Generation wurden, ohne bei der Auswahl zu wissen, ob sie klug waren oder nicht. Darauf meinten seine Kritiker, es müsse ein unbemerkter selektiver Faktor am Werk sein, die weniger intelligenten Tiere hätten mehr elektrische Schocks erhalten, deswegen wären sie schwächer gewesen, deswegen hätten sie weniger Nachkommen produziert, also hätte ein selektiver Vorteil zugunsten der intelligenteren Ratten bestanden.

Also wiederholte McDougall sein Experiment, diesmal wählte er tatsächlich die Ratten, die die Eltern der nächsten Generation wurden, aus, nachdem sie getestet worden waren – allerdings nahm er die dümmsten Tiere, die am langsamsten gelernt hatten.

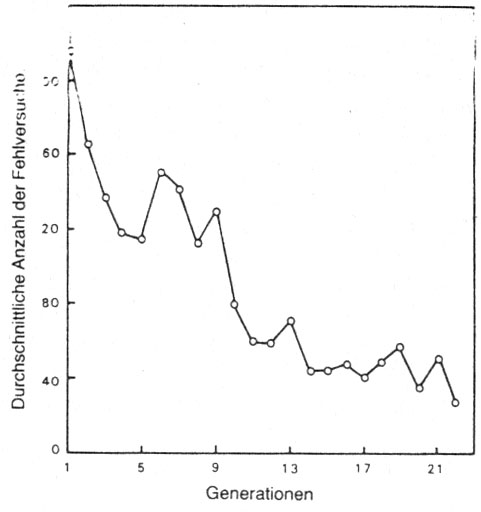

Die Abbildung zeigt die Ergebnisse dieses Versuches.

Die Abbildung zeigt die Ergebnisse dieses Versuches.

In der Senkrechten ist die durchschnittliche Anzahl von Fehlern eingetragen, ein Absinken dieses Wertes bedeutet also eine Steigerung der Lerngeschwindigkeit. Die erste Generation machte durchschnittlich 250 Fehler, bevor sie lernte, den richtigen Ausgang zu benutzen. Die letzte, die 22. Generation, machte durchschnittlich 25 Fehler. Das bedeutet eine zehnfache Steigerung der Lerngeschwindigkeit. Dies ist das Gegenteil dessen, was nach der normalen genetischen Theorie zu erwarten gewesen wäre, denn bei Selektion der dümmsten Ratten hätten die Nachkommen natürlich langsamer lernen sollen.

McDougalls Kritiker konnten an diesem Experiment keinen Fehler feststellen, also blieb ihnen nichts anderes übrig als es zu wiederholen. Einer von ihnen, EA.E. Crew aus Edinburgh, besorgte sich Ratten von genau derselben Rasse, die auch McDougall verwendet hatte, baute das gleiche Wasser-Labyrinth wie McDougall und machte überhaupt alles genauso wie er. Crew fing seine Experimente an, nachdem McDougall seine beendet hatte, und Crew’s Ratten begannen mit einer durchschnittlichen Fehlerzahl von 25. Manche fanden den Ausgang sogar beim ersten Mal. Also gab Crew auf – er konnte nicht erklären, warum seine Ratten so schnell lernten, und MacDougall konnte das auch nicht.

Das nächste Experiment dieser Art wurde in Australien durchgeführt, von W. Agar an der University of Melbourne. Er änderte die Bedingungen geringfügig, und seine Ratten lernten nicht ganz so schnell wie die von Crew, aber immer noch schneller als McDougalls erste Generation. Agar führte den Versuch über 50 Generationen durch, wofür er 25 Jahre brauchte. Genau wie McDougall fand er, daß seine Ratten von einer Generation zur nächsten besser wurden, die Lerngeschwindigkeit steigerte sich. Er überprüfte auch die Lerngeschwindigkeit von Ratten, die nicht Nachkommen von trainierten Tieren waren, sondern ganz gewöhnliche Tiere derselben Rasse, die nicht mit getesteten Tieren verwandt waren, die keine Väter, Mütter oder Großeltern hatten, die schon einmal getestet worden waren. Agar fand, daß auch diese Versuchstiere besser wurden, und daß die Steigerung der Lerngeschwindigkeit sich bei allen Ratten dieser speziellen Art bemerkbar machte.

Das ist also ein Effekt von der Art, wie ihn die Hypothese vorhersagt. Die Ergebnisse liegen vor, und es ist eines der längsten Experimente in den Annalen der Rattenpsychologie. Ich habe festgestellt, daß es noch andere Beispiele für solche Phänomene in der Literatur gibt.

Konventionell ausgerichtete Biologen werden sich von diesen Beweisen nicht überzeugen lassen. Sie werden vielleicht sagen, es müsse noch eine andere Erklärung dafür geben, vielleicht sei der Versuchsleiter immer besser bei der Durchführung des Experiments geworden, oder etwas Ähnliches. Und das ist natürlich durchaus möglich. Ich sage nicht, daß meine Interpretation die einzig mögliche ist, ich sage nur, daß die Ergebnisse vom Standpunkt meiner Hypothese aus sehr interessant sind und sie zu stützen scheinen, und daß es daher der Mühe wert wäre, diese Theorie mit Hilfe von genau kontrollierten Verfahren zu überprüfen, die das Verhalten von Tieren wie etwa Ratten untersuchen. Und ich glaube, es ist möglich, Experimente zu entwickeln, die eindeutige Resultate liefern würden.

Der gleiche Vorgang wie der eben beschriebene sollte nach der Theorie natürlich auch bei Menschen geschehen. So sollte es zum Beispiel im Laufe der letzten 100 Jahre für Kinder leichter geworden sein, das Fahrradfahren zu lernen, weil Millionen von Leuten es bereits gemacht haben. Offensichtlich lernen Kinder heute auch im allgemeinen schneller, Fahrrad zu fahren, aber wiederum gibt es hier natürlich andere mögliche Erklärungen: bessere Fahrräder, mehr Motivation, bessere Lernmethoden und dergleichen. Es ist also schwer, eindeutige Ergebnisse zu bekommen. Aber wo immer ich nach Bestätigung für die Theorie gesucht habe, haben die Fakten sehr gut zu den Vorhersagen gepaßt, die sie macht. Ich meine also, so weit hergeholt scheint sie nicht zu sein, wenn wir uns tatsächlich die Fakten ansehen

Die Theorie führt zu einer sehr neuen Sicht der Vererbung. Nach der üblichen Ansicht hängt Vererbung fast völlig von der Information ab, die in der DNS, der Desoxyribonucleinsäure der Gene, verschlüsselt ist. Darin sollen alle Informationen enthalten sein, die für die Herausbildung des Organismus und für die Instinkte, das ererbte Verhalten eines Tieres, notwendig sind. Es ist offensichtlich, daß die DNS, die chemische Zusammenssetzung der Gene, eine wichtige Rolle in der Vererbung spielt, und die Erkenntnisse der Genetik haben uns gezeigt, daß Unterschiede in der DNS zu erblichen Unterschieden zwischen Organismen führen können. Ich behaupte nun, daß die Form und die Organisation von Organismen direkt von früheren Mitgliedern der eigenen Spezies ererbt wird, und zwar auf dem Wege der morphischen Resonanz. Wie passen diese beiden Ansichten der Vererbung zusammen? Zunächst scheinen sie miteinander in Konflikt zu stehen. Wenn wir sie aber näher betrachten, sehen wir, daß sie nicht im Widerspruch stehen, sondern komplementäre, einander ergänzende Sichtweisen zum Verständnis der Vererbung darstellen.

Das beste Mittel, dies zu verstehen, ist der Vergleich mit einem Fernsehempfänger. Stellen Sie sich vor, Sie wüßten nicht, wie Fernsehen funktioniert, und sie sehen ein Fernsehgerät, da sind Bilder auf dem Schirm, Sie sehen kleine Leute, die reden oder tanzen oder Musik machen. Ihre erste und naheliegende Hypothese wird sein, daß da im Apparat kleine Leute sind, deren Abbild Sie auf dem Schirm sehen. Manche Kinder glauben das tatsächlich. Sie können diese Theorie überprüfen, indem Sie im Inneren des Empfängers nachsehen, und wenn Sie das tun, sehen Sie keine kleinen Leute. Dann könnten Sie sagen, na ja, die Leute müssen wirklich sehr klein sein, mikroskopisch klein und in den Drähten. Sie untersuchen die Drähte und sehen immer noch keine kleinen Menschen. Dann können Sie sagen, sie müssen so klein sein, daß man sie nicht einmal mit dem Mikroskop entdecken kann, oder Sie könnten eine differenziertere Hypothese entwickeln: Sie könnten sagen, daß die kleinen Leute als Ergebnis von komplizierten Interaktionen zwischen den einzelnen Teilen des Fernsehapparates, den Transistoren, Drähten, Kondensatoren usw. auf dem Schirm erscheinen. Außerdem spielt die Energie, die in den Apparat kommt, eine Rolle, wenn man den Stecker zieht, hören die Bilder auf, wenn man ihn wieder in die Steckdose tut, kommen sie wieder. Ähnliches passiert, wenn man im Gerät Drähte entfernt und wieder einsetzt. Sie könnten also denken, daß die Bilder aus komplizierten Interaktionen zwischen den Teilen des Geräts entstehen. Diese Teile sind aus normalen chemischen Substanzen wie etwa Kupfer oder Silizium, man kann sie analysieren, sie haben nichts Geheimnisvolles an sich, und sie interagieren miteinander in einer Weise, die noch nicht ganz geklärt ist. Aber in, sagen wir, 15 oder 20 Jahren werden wir imstande sein, die Bilder vollständig durch komplizierte Interaktionen zwischen den Teilen zu erklären.

Genauso, denke ich, ist die Position der herkömmlichen mechanistischen Biologie. Wenn man jemandem mit dieser Einstellung sagt: Es gibt da Einflüsse, die kommen von außerhalb des Geräts, sie sind unsichtbar, man kann sie nicht sehen, berühren oder mit anderen Sinnen erfassen, aber die Bilder der Leute auf dem Schirm kommen tatsächlich von außen, könnte er das leicht abtun. Das sei eine sehr vage Theorie, es gebe überhaupt keine Beweise für solche Einflüsse, das sei der pure Mystizismus oder ähnliches. Oder man könnte die Idee auch ernsthaft überprüfen, könnte sagen, nun, wenn es etwas ist, muß es etwas wiegen, denn nichts existiert, wenn wir es nicht messen können. Also wiegen wir das Fernsehgerät in eingeschaltetem und ausgeschaltetem Zustand, es wiegt beide Male gleich viel, und das beweist, daß nichts von außen in das Gerät hereinkommt. Sehr überzeugend. Aber falsch. Nicht ganz falsch, weil die Teile des Fernsehgerätes wohl wichtig sind; aber ebenso wichtig sind die Sendungen, auf die es eingestellt ist, die unsichtbaren Felder, die es empfängt.

Was nun meiner Meinung nach bei der Vererbung geschieht, ist folgendes: Das befruchtete Ei hat bereits eine Struktur, die von seinen Genen abhängt, und welche Arten von Proteinen es in seiner Entwicklung produziert, hängt ebenfalls von seiner Erbmasse ab. Aber diese Proteine und die DNS sind wie die Drähte und Transistoren im Fernsehempfänger. Sie sind die Bauteile des Empfängers. Wenn man eine Drahtverbindung verändert oder den Wert eines Kondensators oder Widerstands, dann verändert sich das Bild auf dem Schirm. Ebenso werden Veränderungen im genetischen Material das Empfangssystem und damit die Qualität der Bilder beeinflussen. Aber die Bilder selbst sind in dieser Information nicht enthalten. Vielmehr dient die DNS zum Aufbau des Empfangssystemes, und die Organisation der Form und des Verhaltens kommt durch morphische Resonanz zustande, durch das kollektive Gedächtnis der Spezies. Die DNS spielt also durchaus eine wichtige Rolle in der Vererbung; was ich sage, steht keineswegs im Widerspruch damit, daß der Einfluß genetischer Faktoren in der Vererbung nachgewiesen ist. Diese beiden Auffassungen sind völlig komplementär. DNS steuert die Sequenz von Aminosäuren und Proteinen und in einem gewissen Ausmaß die Proteinsynthese, aber möglicherweise nicht mehr. Die anderen Arten der Organisation werden von den morphogenetischen Feldern bestimmt.

Dies führt also zu einer neuen Sicht der Vererbung und damit auch der Evolution. Denn die gängige Theorie der Evolution baut auf der Mendel’schen, also der genetischen Theorie der Vererbung auf. Und wenn diese falsch oder zu begrenzt ist, wenn Vererbung mit einem kollektiven Gedächtnis zu tun hat, dann existiert auch die Möglichkeit der Vererbung von erworbenen Eigenschaften, nicht nur auf die Nachkommen von Eltern, die etwas Neues gelernt haben, sondern potentiell auf alle Mitglieder der Spezies. Diese Theorie geht also weiter als die Vererbungslehre von Lamarck. Sie läßt auch Verbindungen zwischen verschiedenen Arten möglich erscheinen; danach wäre es denkbar, daß eine Spezies in einem Teil der Welt die morphogenetischen Felder einer anderen Art in einem anderen Teil der Welt aufnimmt und dadurch ähnliche Strukturen in sehr verschiedenen Organismen auftauchen, die vielleicht durch große Entfernung oder sogar durch ein sehr langes Zeitintervall voneinander getrennt sind. Die Kennzeichen von bereits ausgestorbenen Arten könnten dann wieder auftauchen. Solche Vorgänge sind aus dem Studium der fossilen Geschichte bekannt, man spricht dann von „Atavismen“.

Eine der radikalsten Implikationen dieser Theorie betrifft unsere Auffassung von Gedächtnis. Denken wir daran, was bei der morphischen Resonanz vor sich geht: Organismen werden von anderen Organismen aus der Vergangenheit beeinflußt, und diese Wirkung ist umso größer, je ähnlicher diese Organismen einander sind. Nun können wir fragen: Welchem Organismus der Vergangenheit ähnelt jeder Organismus am meisten? Wer in der Vergangenheit war mir ähnlicher als jeder andere Organismus? Die Antwort lautet: ich selbst. Jeder Organismus, jedes System, jeder Kristall, jedes Atom, jedes Molekül ist sich selbst in der unmittelbaren Vergangenheit ähnlicher als jedem anderen System. Die direkteste Einwirkung durch morphische Resonanz ist also die aus der eigenen unmittelbaren Vergangenheit. Dies erklärt meiner Meinung nach, warum die Form eines Systems im allgemeinen über die Zeit stabil bleibt, obwohl seine materiellen Bestandteile ständig wechseln. Die Materie unseres Körpers ist einem dauernden Austausch unterworfen, wir nehmen jeden Tag neue Substanz auf und verlieren andere oder scheiden sie aus. Trotzdem bleibt unsere Form mehr oder weniger die gleiche. Der Prozeß der Selbst-Resonanz, der Resonanz mit den eigenen vergangenen Zuständen, hilft, die Form zu bewahren und aufrecht zu erhalten. Auf der Verhaltensebene bedeutet diese Selbst-Resonanz einen direkten Einfluß vergangener Zustände auf den gegenwärtigen. Wenn man etwas früher gelernt hat oder oft getan hat, Fahrrad fahren zum Beispiel, dann beeinflußt dies die Art, wie man jetzt Fahrrad fährt. Und die Erinnerung dieser Fertigkeit muß nicht im Gehirn gespeichert werden, sie kann direkt aus der Vergangenheit durch morphische Resonanz wirken.

Ich bin der Ansicht, daß Erinnerungen nicht im Gehirn gespeichert sein müssen. Unser Gehirn könnte eher wie ein Empfänger als wie ein Speicher funktionieren. Wenn ein Teil des Empfangssystems beschädigt wird, könnten wir vielleicht nicht imstande sein, Zugang zu bestimmten Erinnerungen zu bekommen. Wenn wir einen Teil des Fernsehgeräts entfernen, bekommen wir unter Umständen das eine oder andere Programm nicht mehr herein. Das beweist aber nicht, daß die Information dieser Programme in dem Teil gespeichert war, den wir entfernt haben. Wenn wir nach einer Gehirnverletzung bestimmte Erinnerungen verlieren, so beweist das nicht, daß diese Erinnerungen in dem Teil des Gehirns gespeichert waren, der verletzt wurde. Wenn bestimmte Erinnerungen durch Stimulation eines bestimmten Teils des Gehirns hervorgerufen werden, so muß das nicht bedeuten, daß diese Erinnerung an der stimulierten Stelle gespeichert ist; wir können schließlich auch einen Fernsehempfänger an einer bestimmten Stelle stimulieren und er springt dann vielleicht auf einen anderen Kanal um. Man empfängt dann andere Bilder von einem anderen Sender. Das heißt aber nicht, daß der von uns stimulierte Teil diese Information enthält.